「transformers の中身、結局よく分かってないな…」とモヤモヤしたこと、ありませんか?

モデルは呼べる。Fine-tune もなんとなくできる。でも「中で何が起きてるか説明して」と言われた瞬間に手が止まる——あの感じです。

そんなところに出てきたのが、Qiita の「ゼロから作るLLM Part4: GPT-2の実装」。

一言でいうと、「LLM界の“自作TCPスタック入門”」みたいな記事です。

一言でいうと:LLM界の「TCPを自作してみた」記事

世の中の多くの GPT-2 解説はこうです。

from transformers import GPT2LMHeadModel

model = GPT2LMHeadModel.from_pretrained("gpt2")

…で終わり。

正直、これって「ソケットの中身は知らないけど requests.get は書けます」レベルの理解なんですよね。

今回の記事は真逆で、

- 埋め込み

- 位置埋め込み

- マルチヘッド自己注意

- 残差接続+LayerNorm

- MLP

- 出力の LM Head

- そして因果マスクと生成ループ

を PyTorch で全部手書きしていくスタイルです。

ネットワークエンジニアが一度は「おもちゃ TCP スタック」を自作するように、

LLM エンジニアも一度は「おもちゃ GPT-2」を自作しておけ、というメッセージに聞こえました。

何がそんなにエラいのか:Hugging Face との「決定的な違い」

「動くコード」ではなく「読めるコード」を優先している

Hugging Face のコード、読んだことがある方なら分かると思いますが、

- 互換性

- 過去のモデル

- 膨大なコンフィグ

- 最適化オプション

が全部詰め込まれていて、初学者の教材としてはかなりキツい。

今回の GPT-2 実装は、それらを全部捨てて、

- Q/K/V の Linear

[batch, head, seq, dim]への reshapetriuでの因果マスク- cross entropy での next-token loss

- 単純なループでのオートレグレッシブ生成

だけにフォーカスしている。

ぶっちゃけ、「これ以上削ると GPT-2 じゃなくなる」ギリギリまでミニマムにしていて、そこがものすごく良いです。

「黒魔術ポイント」が全部コード上に露出している

実務で詰まりがちな“黒魔術ポイント”って、だいたい以下のあたりに集中しますよね 🤔

- Q/K/V のテンソル shape が合わない

- マスクが片対角行列なのか、ブロードキャストなのか分からない

view/transpose/contiguousの組み合わせで地獄を見る- logits と labels の次元がズレて loss が NaN になる

この記事はここをあえて隠さず、全部ベタに書いてある。

読みながら「ここをいじれば top-k sampling 入れられるな」「KV キャッシュはここに差し込めばいいな」とイメージできる構造になっているのがポイントです。

Hugging Face と比べると:

- Hugging Face

- プロダクション寄り

- 機能モリモリ・コード読みにくい

- すぐ動くが、内部は見えにくい

- この記事の GPT-2

- 教材寄り

- 機能は最小限・コードは読みやすい

- 「なぜそうなるか」が追える

正直、「LLMを使うだけなら Hugging Face」でいいんですが、

「LLMを拡張・改造する側に回りたいなら、こういう素の実装を一度は通過すべき」です。

「ゼロから作る」路線が、他のチュートリアルに突きつけているもの

この記事って、新しいライブラリを出しているわけでも、圧倒的に速い実装でもないんですよね。

それでも価値があるのは、「チュートリアルのレベル感」を一段引き上げているからです。

ありがちな「LLM入門」の問題

よくあるパターン:

- OpenAI / Hugging Face の API を叩く

RAGとエージェントの単語を出す- Notebook が動く

- 「はい、LLM入門終わりです」

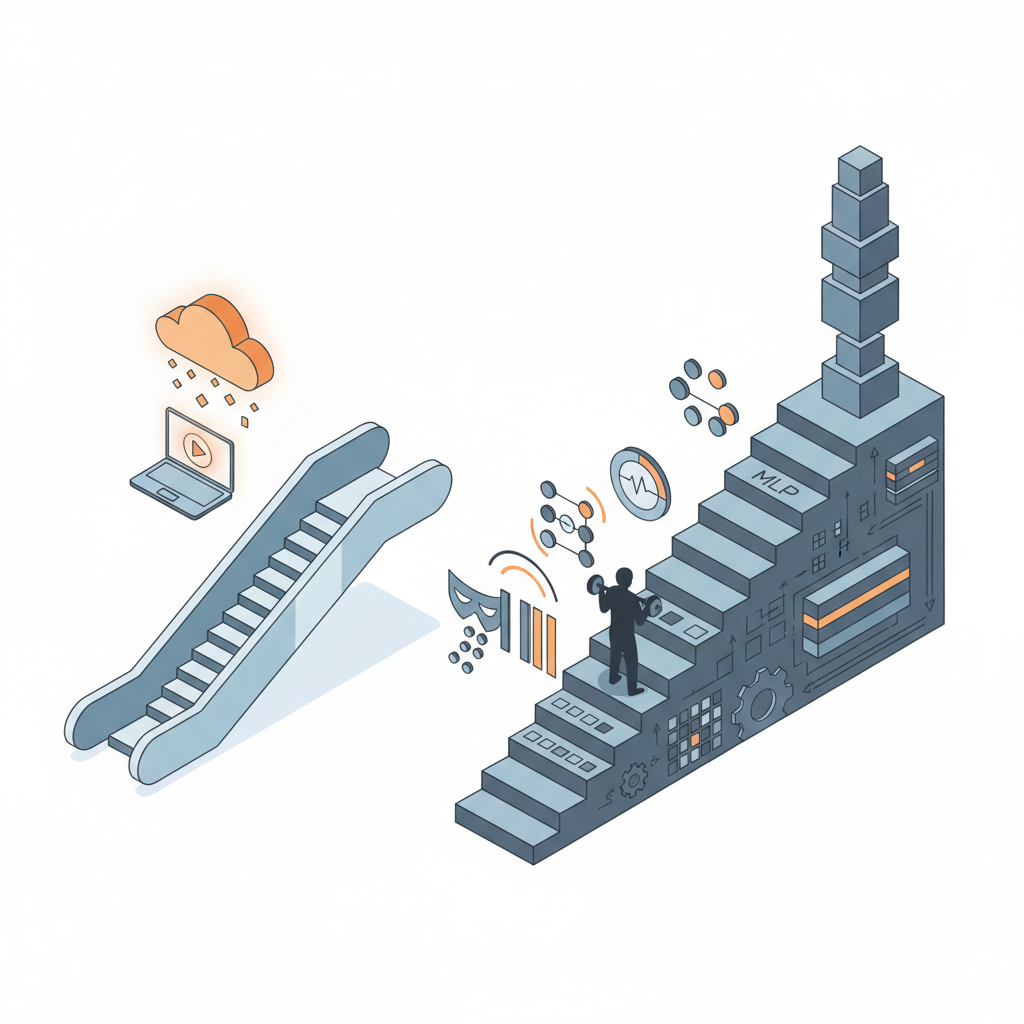

ぶっちゃけ、これだと道具として使えるだけで、「エンジニアとしての筋力」はほぼ付かないんですよね…。

- トークナイザーはどう動いてる?

- なんで「未来のトークン」を見ないようにしないといけない?

- LayerNorm をどこに挿すと何が変わる?

- なぜ MLP の中間次元が d_model の 4 倍くらいなの?

こういう問いに答えられないまま、RAG やエージェントに飛びつくと、

トラブルが起きたときに原因特定もチューニングもできない「お祈り運用」になりがちです。

今回の GPT-2 実装シリーズは、その一段手前——

「LLM をきちんと理解して扱えるエンジニア」になるための、基礎体力作り

にかなりちゃんとフォーカスしている。

ここが、単なる「API と仲良くなろう記事」との決定的な違いだと感じました 💪

とはいえ…懸念点もきっちりある

ここまでベタ褒めしましたが、当然デメリットもあります。

スケールさせるには、正直まったく足りない

記事の実装は教育用スケルトンです。

なので当然ながら、以下は一切入っていません。

- FlashAttention 系の高性能 Attention

- KV キャッシュによる高速生成

- 量子化

- 分散学習

- 巨大コーパス向けのデータパイプライン

このまま 10 億パラメータ級を回そうとすると、

- メモリで即死する

- 学習時間が現実的でない

のどちらか、もしくは両方にぶち当たります。

「この実装をそのまま業務用 GPT-2 にしよう」は完全に悪手です。

学習済み重みの世界に出るには、まだ橋が必要

アーキテクチャは分かる。動く。

でも「pretrained GPT-2 の重みを流し込んで高品質生成したい」となると、別の戦いが始まります。

- 公式 GPT-2 の設定との完全一致

- 層の数、head の数、dim など

- 初期化や LayerNorm のパラメータの扱い

- Weight tying の有無と場所

正直、Hugging Face の重みを直で読み込めるところまで作り込むのは、それはそれで大仕事です。

この記事はそこまでは踏み込んでいないので、「実戦投入モデルの土台」として使うには、エンジニア側の追加作業がかなり要求されます。

「自前実装を持つ」という技術的負債

ゼロから実装するのは気持ちいいんですが、その瞬間から:

- PyTorch バージョンアップの影響を自分で吸収する

- バグも最適化も自力対応

- 新しい論文のアイデアを取り込むたびに自前コードをいじる

というフル自社開発フェーズに突入します。

正直、プロダクションで「自前 GPT-2 実装」を抱えるのは、それなりの覚悟がいるんですよね。

多くのチームにとっては、

- 推論・配備:Hugging Face / vLLM など既製品

- 学習・内部理解:こういうミニマル実装

と完全に役割分担した方が健全だと思います。

じゃあこれ、どこで使うべきなのか?

✅ 使うべき人・場面

- LLM をブラックボックスのまま使いたくないエンジニア

- 新しい Attention 手法や正規化を試したい研究寄りエンジニア

- 社内勉強会や社内トレーニングで、

- 「transformer 内部をきちんと教えたい」リードエンジニア

- 将来的に

- 自前 LLM の pretrain / fine-tune インフラを作りたい人の「第一歩」

こういう人には、この記事の GPT-2 実装はかなり刺さるはずです。

どこを変えれば rotary embedding にできるか?

どこに LoRA モジュールを差し込めばいいか?

といった改造ポイントが視認できるコードになっているので、「論文を読んで実装する」の足場としても優秀です。

❌ そのまま使うべきでない人・場面

- 今すぐ業務アプリに LLM を載せたい

- 大規模モデルの推論パフォーマンスが最優先

- MLOps チームが少人数 or いない

この場合は、正直

- OpenAI / Azure OpenAI / Anthropic などの API

- あるいは Hugging Face + vLLM / SGLang

を素直に使うべきです。

この GPT-2 実装はプロダクション用ライブラリではなく、「理解と実験用の教材」だと割り切った方が良い。

結論:プロダクションで使うか?正直まだ様子見。でも「読む価値」はデカい

正直に言うと、この実装をそのままプロダクションに持ち込むのはおすすめしません。

性能も、エコシステムも、保守性も、Hugging Face や各種推論フレームワークには到底及びません。

ただし——

- LLM をただの API ではなく「自分でいじれる技術」にしたい

- LLM 系の論文を読んだときに、「どこをどう直せばいいか」腹落ちさせたい

- チーム全体の「LLMリテラシー」を底上げしたい

と思っているなら、この記事のようなミニマル GPT-2 実装を一度ちゃんと追う経験は、かなりコスパがいい投資です。

ぶっちゃけ、LLM の世界は「とりあえず動く」だけなら誰でもできます。

これから差が付くのは、

- 中身を理解して、

- 必要なときに自分で分解・再構成できるか

の部分です。

その意味で、「ゼロから作るLLM Part4: GPT-2の実装」は、

“LLM を本気で扱いたいエンジニア”が、一度は通っておくべき TCP 自作入門のような記事だと感じました。

プロダクションは様子見。でも、エンジニアとしての筋トレ教材としてはかなり推せる、というのが自分の率直な結論です 💡

コメント