「またエージェントフレームワーク増えたの?」「マルチモーダル用に別モデル立てるの、そろそろやめたいんだけど…」

そんなことを思いながら、LLMまわりのアーキ図を更新するたびにため息ついていませんか?🤯

2025年の Google DeepMind の “Year in Review” を読んで、正直いちばん最初に思ったのはこうでした。

「あ、これ **“ポスト・LangChain 時代” の設計図を Google が本気で取りに来たな」

この記事では単なるニュースまとめではなく、「エンジニア目線で、これをどう受け止めるか」「どこまで乗るべきか」を、かなり主観強めで整理してみます。

- 一言で言うと:エージェント界の Kubernetes が来た

- 何が一番ヤバい(=嬉しい)のか:本当の killer feature は「1 API でエージェント化」

- マルチモーダル “ちゃんと動くやつ” がようやく来た感

- Science / Robotics は「ゲームチェンジ」だけど、ほとんどの人には間接的インパクト

- ロボット界隈は、ようやく「言語 → 行動」がマジで使えるラインに

- 競合視点:Google vs OpenAI vs それ以外

- 正直ここが怖い:ロックインと「中身の見えなさ」

- セーフティ強化は「普通の開発者には朗報、攻める人には足かせ」

- じゃあ、プロダクションで使うか?正直なところ…

- 最後に:2025 DeepMind は「楽をくれる」けど「考える自由」をちょっと奪う

一言で言うと:エージェント界の Kubernetes が来た

Google DeepMind 2025 のブレイクスルーを一言で言うなら、

「エージェント界の Kubernetes を、Google が公式に配布し始めた年」

です。

- 以前:

- LangChain / LangGraph

- 自作の planner / tool-caller / retriever

- テキスト用 LLM + Vision 用モデル + Embedding 用モデル…

- 2025 DeepMind 後:

- 1つの Gemini 系マルチモーダルモデル + Google 純正のエージェントフレームワーク

- その裏に Planner / Worker / Verifier / Safety / Long context が全部「隠されている」

Kubernetes 登場前にみんながバラバラなデプロイスクリプトを書いていたように、

ここ数年、我々は バラバラなエージェントオーケストレーション を書いてきました。

DeepMind はそれを「プラットフォームの責務」にしに来た。

これが 2025 年の一番デカい意味合いだと感じています。

何が一番ヤバい(=嬉しい)のか:本当の killer feature は「1 API でエージェント化」

技術的にはいろいろ出ていますが、エンジニアにとっての 本当の killer feature はこれだと思っています。

「1回の API コールの裏で、Planner / Tool 呼び出し / Verifier まで全部やってくれる」

具体的には:

- モデル側に

- 推論用の search / Tree-of-Thought 的探索

- Verifier モデルによる自己チェック

- Tool call の orchestration

- プラットフォーム側に

- Tool schema (JSON)

- ReAct ループ

- エラーリカバリ・ガードレール

がビルトインされていて、開発者は

{

"tools": [

{

"name": "query_warehouse",

"parameters": { ... }

}

]

}

みたいに **「できることの型」だけ宣言すればいい。

ぶっちゃけ、LangChain や自作エージェントでやっていた「モデルに手順を考えさせて、function_call を拾って投げ直して…」という儀式の 7〜8割は、

「Google による managed service」になった と思っていいです。

正直、エンジニアとしてはめちゃくちゃ楽になります。

でも同時に、「これにどこまで乗るか?」はかなり戦略的な選択になります。

マルチモーダル “ちゃんと動くやつ” がようやく来た感

「テキスト + 画像 + PDF + ちょっとコードも書いて」で一気通貫にやりたい、って要求はここ 2 年くらいずっとありましたが、

実務レベルではこんなパターンに陥りがちでした。

- 画像 → Vision API

- テキスト → LLM

- ドキュメント → 別の embedding + RAG パイプライン

- 最後にアプリ側でがんばって全部まとめる

DeepMind 2025 世代の Gemini スタックは、ここを 実装レベルでかなり潰しに来ている ように見えます。

- テキスト / 画像 / 音声 / 動画 / 構造化データを 1モデル で扱う

- 10万トークン級の長文コンテキスト を、マルチモーダル含めて処理

- CoT を「プロンプトハック」ではなく モデル設計 & 推論アルゴリズム側に組み込んだ

結果として開発者体験はこう変わるはずです:

- 「この PDF とこのスプレッドシートとこの動画を読み込んで、

差分を分析して Python スクリプトを書いて」→ 1 API で完結 しやすくなる - 「Let's think step by step」を何回も書くような prompt hack は、むしろノイズになり始める

正直、「マルチモーダルやりたいからモデルを 3 個並べよう」みたいな設計は、2025 年時点でもうレガシー入り だと思っています。

Science / Robotics は「ゲームチェンジ」だけど、ほとんどの人には間接的インパクト

DeepMind らしいのが、やっぱり 科学・工学・ロボティクス への異常なコミットです。

- ポスト AlphaFold 世代:

- タンパク質–タンパク質、タンパク質–リガンド、RNA、材料など

- しかも静的構造ではなく、システムの挙動 (time-evolution) まで予測

- シミュレーション代替モデル:

- CFD、天気 / 気候、分子動力学の surrogate

これ、対象ドメインの人たちからすると、

「計算コストがバカ高いシミュレーションの 1 段目・2 段目を、

ごっそり DeepMind にオフロードできる未来」

にかなり近づいています。

設計の初期フェーズで「とりあえず 1000 パターン雑にスクリーニング」みたいなことが現実的になる。

一方で、典型的な Web / SaaS のエンジニア目線だと、これらは

「自分のアプリから叩ける超専門 API が増える」

というかたちで効いてきます。

- 「プロテイン設計 API」

- 「材料構造最適化 API」

- 「高速天気予測 API」

みたいな感じで Google Cloud 側から出てきて、

それを自社サービスに組み込む、という文脈ですね。

なので、

「科学ドメインの人には人生変わりうるブレイクスルー」

「それ以外の人には、クラウドに新しい “超強力マイクロサービス” が追加された」

という温度差になると思います。

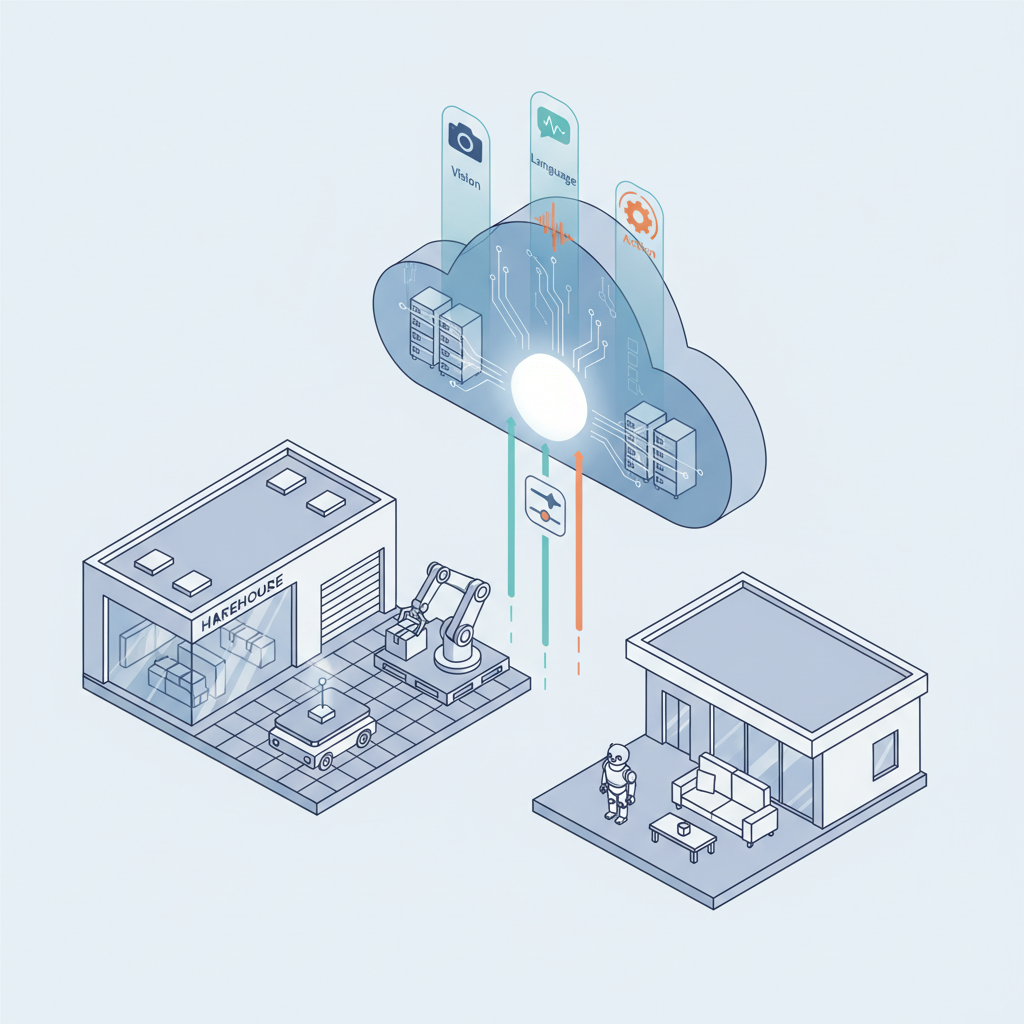

ロボット界隈は、ようやく「言語 → 行動」がマジで使えるラインに

ロボット系も 2025 年の DeepMind はかなり攻めています。

- 複数ロボット・複数タスクで学習した 汎用ポリシー

- Vision + Language + Action を一体化した VLA モデル

- 自然言語で「こうして」「ああして」でタスク指定

これも感覚的には、

「RT-2 や Gato で見えていた “片鱗” が、

2025 でようやく “プロダクション候補レベル” に昇格した」

感じがあります。

ある意味で

「物理世界を Google Cloud の一部にする」

っていう、ずっと DeepMind / Google がやりたかったであろう未来に一歩近づいた年とも言えます。

物流 / 倉庫 / 工場 / ホームロボット系のエンジニアにとっては、

- 「ポリシーを毎回ゼロから学習」→ “Policy as a Service” を叩いて fine-tune 最小限

- 「行動シーケンスをコードで書く」→ 自然言語で behavior script を書く

にだんだん変わっていくと思います。

競合視点:Google vs OpenAI vs それ以外

ここからが一番おもしろいところで、

この 2025 年の DeepMind の動きは、OpenAI / 他社と比べると、かなり性格がはっきりしています。

Google DeepMind が強いところ

- マルチモーダル + 長文コンテキスト を「普通に」使えるレベルに

- Gmail / Docs / Sheets / Calendar / Drive / Vertex AI まで含めた

エンドツーエンドのエージェントプラットフォーム - 科学 / ロボティクスといった 物理世界寄りドメインへの強さ

つまり、

「Google の全部を道具箱にした AI オーケストレーションレイヤー」

を作りに来ている。

OpenAI が依然として強いところ

- テキスト・コードの純粋な UX(GPT-4 系 / o3 系の “使ってて気持ちいい” 感)

- ChatGPT / GPTs のエコシステム

- どのクラウドにもあまりロックインされない API 専業のシンプルさ

特に、

「特定クラウドに縛られたくない」「Office 365 まわりを軸にしたい」 企業にとっては、

OpenAI + Microsoft のほうがまだ合理的なケースも多いです。

この構図で、一番割を食うのは誰か?

正直、2025 年の DeepMind の年次レビューを見て一番ダメージを受けるのは:

- LangChain / 自作エージェントフレームワーク

- 「マルチモーダルできます」だけが売りのスタートアップ

- 「科学 AI やります」系で、データや規制対応に強みがない会社

だと思います。

エージェント orchestration と マルチモーダル が

「クラウドプラットフォームの標準機能」 になりつつあるので、

付加価値が「LangChain っぽい抽象を提供します」だけの事業は、

正直かなり厳しいポジションに追い込まれるはずです。

正直ここが怖い:ロックインと「中身の見えなさ」

もちろん、良い話ばかりではありません。

2025 DeepMind スタックには、エンジニアとして見ておきたい “闇” も結構あります。

ベンダーロックインがガチで深くなる懸念

- エージェントフレームワーク

- Tool schema

- Google Workspace / Drive / Calendar との深い統合

- Tenant ごとのセーフティポリシー

このあたりをフルで使い始めると、

「アプリのビジネスロジック = Google のエージェント設定 + ツール群」

みたいな状態になりがちです。

これを OpenAI / Anthropic / 自前モデルに移そうとすると、

- Tool schema の互換層を書き直し

- セッション管理・メモリ・ガードレールを再実装

- Google 特有の API (Gmail, Docs など)の置き換え or 削除

が必要で、事実上かなり重い再開発 になります。

Kubernetes だってロックインだろ、というツッコミはありますが、

少なくとも K8s はオープンで複数ベンダーがあります。

DeepMind のエージェントレイヤーは、そこまでオープンではない。

「AI インフラのかなり深いところを、1 社に明け渡す」

という意思決定をしている、という自覚は持っておいたほうがよさそうです。

中のオーケストレーションがブラックボックス化する

Planner / Worker / Verifier / Safety Critic / Long-context キャッシュ…

これらが 1 API コールの裏でぐるぐる回るわけですが、

デバッグする側からすると、こうなります。

- なぜこのツールが選ばれたのか?

- なぜここでエラーリカバリが走ったのか?

- なぜブロックされたのか?どの Safety layer が原因なのか?

「ログを出して欲しいポイント」が、だいたい全部プラットフォームの”内側” にあります。

もちろん Google もある程度のトレース機能は出してくると思いますが、

- step-by-step の挙動の完全再現

- 特定の verifier の判定だけを切り替えて A/B したい

といった、「ちゃんと分解して検証したい」要求には、なかなか応えてくれない可能性が高い。

「アプリの不具合なのか、Google のエージェント層の気まぐれなのか」

切り分けに時間を食われる未来がかなり見えます。

コストとレイテンシが “見かけ以上” になる

Planner → 複数案生成 → Worker → Verifier → Safety Critic…

とやっていくと、実際には内部で 複数回 LLM を叩く ことになります。

- 課金は「表向きのトークン数」ベース

- でも裏では CoT / search / verification で数倍使っているかもしれない

という世界観です。

つまり、

「このエンドポイントを 1 回叩くと、

実は内部では 3〜5 回くらいモデルを回してるかもしれない」

ということを前提に、SLO / コストを設計 しないといけない。

人間から見た「1 回の呼び出し」が、

- 実は 1 モデル呼び出しなのか

- 実は 5 モデル ensemble なのか

は、外からは基本見えない。

ここにけっこうな 見積もり誤差 が出てくると思います。

セーフティ強化は「普通の開発者には朗報、攻める人には足かせ」

DeepMind のセーフティ周りも、2025 でかなり厚くなっています。

- プレトレーニング段階でのデータフィルタリング

- SFT + RLHF / RLAIF with “constitutional policies”

- 生成時の Safety classifier / critic によるブロック・書き換え

- テナント単位でのポリシー設定

これ自体は 「普通にプロダクション用途で LLM を使いたい企業」には朗報 です。

- 意図しないハルシネーション的回答や、危険な出力のリスクをある程度抑え込める

- セキュリティチーム / 法務チーム向けに説明もしやすい

一方で、

- セキュリティリサーチ

- レッドチーミング

- バイオ / 合成生物系の高リスク領域

- 攻撃手法の PoC

みたいな、「グレーゾーンをあえて攻めないといけない」領域では、

「正当な用途でも容赦なくブロックされる」

という事態が増えるはずです。

実際にこういう用途では、

- 特別なエンタープライズ契約

- 組織内 IRB 的な審査

- 専用 sandbox 環境

が必要になってくるでしょう。

じゃあ、プロダクションで使うか?正直なところ…

ここまで見てきたうえで、

「じゃあ 2025 世代の DeepMind / Google スタック、プロダクションでどう使う?」

という話を、個人的な結論ベースでまとめます。

Google Workspace / Google Cloud がメインの会社なら…

→ 正直、かなり前向きに “本命候補” にしていい と思います。

理由はシンプルで:

- ワークスペースとの統合度が段違い

- セキュリティ / 管理面での一貫性

- エージェントフレームワークが「純正」である安心感

この条件下では、OpenAI 単体をメインに据えるより、

「DeepMind + Google Cloud によせて設計した方が、全体の摩擦は小さくなる」 ケースが多いはずです。

ただし、

- ビジネスロジックをエージェント設定にベタ書きしない

- 自社ドメインの “コアなツール” は、できるだけ vendor-agnostic な API として切り出す

といった 抽象レイヤー を挟んでおくのは必須だと思います。

マルチクラウド / マルチベンダー前提のプロダクトなら…

→ 正直、まだ「様子見 + 軽く触る」くらいが妥当 だと考えています。

理由:

- DeepMind のエージェントフレームワークをフルで前提にすると、

OpenAI / Anthropic / 自前モデルへの乗り換えがかなり重くなる - 逆に、DeepMind の機能を「他社 LLM と完全対称な抽象」でラップすると、

一番おいしい部分(Planner / Verifier など)を活かしきれなくなる

なので、

- コアプロダクト:

→ 依然として vendor-agnostic な設計を維持 - 特定ワークフロー / 機能単位で:

→ DeepMind エージェントを “オプションエンジン” として実験的に組み込む

くらいが現実解かなと感じています。

スタートアップ / 新規プロダクトなら…

ここは難しいですが、ぶっちゃけると、

「何で差別化するのか」次第で判断が真っ二つに分かれる

と思います。

- 差別化ポイントが

「UX / ワークフロー / 特定業界へのドメイン知識」 なら

→ DeepMind のフルスタックに乗って “工数を削る” 戦略 はあり - 差別化ポイントが

「マルチベンダーにまたがる orchestration / 監査 / observability」 なら

→ DeepMind のエージェントをフルで前提にすると、

自分のビジネスを自分で食うことになりかねない

スタートアップほど、

「自分のプロダクトが、5 年後に DeepMind / OpenAI に吸収されていない未来」をどう描くか

を真面目に考えないといけないフェーズに入ったと感じます。

最後に:2025 DeepMind は「楽をくれる」けど「考える自由」をちょっと奪う

2025 年の Google DeepMind のブレイクスルーをざっくりまとめると:

- エージェント orchestration は “自作する時代” から “クラウドの責務” へ

- マルチモーダル + 長文コンテキストは “実験” から “前提” へ

- 科学 / ロボットは、一部領域で本気でゲームチェンジレベル

という感じです。

個人的な感覚を一言でいうなら、

「めちゃくちゃ楽になる。けど、そのぶん設計者としての自由度は確実に減る」

です。

- なんでもかんでもエージェントに丸投げするか?

- どこまで Google の “標準” を受け入れ、どこに自前の抽象を置くか?

- 5 年後に「これ全部別クラウドに引っ越します」と言われてもギリ生き残れる設計になっているか?

このあたりを、アーキテクトがちゃんと意思決定するフェーズ に入ったと思っています。

プロダクションで全賭けするか?

正直、「会社のクラウド戦略と事業戦略次第。デフォルトはまだ部分導入 & 様子見」 というのが、2025 年時点での本音です。

ただ一つだけはっきり言えるのは、

「カスタム LangChain グラフを自慢げに図に描く時代は、もう終わりつつある」

ということです。

これからは、「どのプラットフォームのエージェントレイヤーにどこまで任せるか」その判断力が、

エンジニア / テックリードとしての腕の見せどころになっていくはずです。

コメント