「Llama 使うのが“無難”なのは分かってるんだけど、

・ライセンスの将来がなんか不安

・ベンチマークも最近パッとしない

・それでも他に“これだ”っていう OSS LLM もない…」

そんなモヤモヤを抱えたまま、GPU クラスタの請求書だけが積み上がっていく──

そんな経験、ありませんか?🤔

そのタイミングで NVIDIA が出してきたのが、オープンソース LLM ファミリ 「Nemotron 3」 です。

しかも「NVIDIA 製・フル OSS・GPU 最適化済みリファレンス LLM」というフルセット。

この記事は「Nemotron 3 とは?」を説明するつもりはありません。

テーマはひとつだけです。

Nemotron 3 は、開発者にとって“自由”なのか、それとも“さらに強いロックイン”なのか?

現場目線で、そこを掘ってみます。

一言でいうと「Android に対する Pixel」を NVIDIA がついに出してきた

Nemotron 3 を一言でたとえるなら、

「Android(= OSS LLM エコシステム)に対する Google Pixel(= フルスタック最適化のリファレンス端末)」

にかなり近いです。

- これまでは:

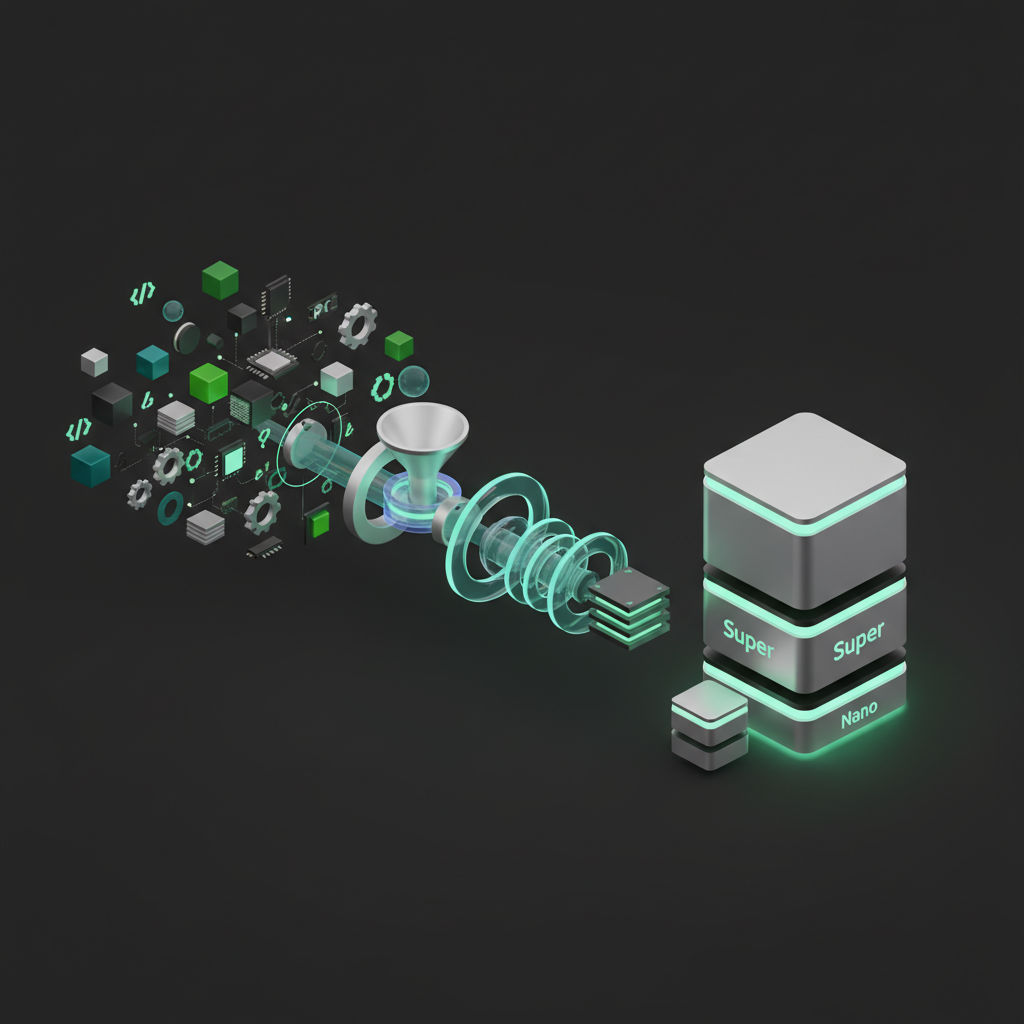

- NVIDIA = GPU + CUDA + TensorRT + Triton + NeMo を提供

- “乗せるモデル”は主に Meta Llama 系 が事実上の標準

- 今回から:

- 「モデルも含めて、NVIDIA が公式の“最適解セット”を出す」

- それが Nemotron 3(Nano / Super / Ultra)の位置づけ

正直、「いつかはこうなるよね」と多くの人が思っていた未来が、

Meta の失速(Llama 4 の微妙さ、Llama 5 なし、Avocado はクローズド説…)とセットで一気に現実化した感じです。

何が本当に新しいのか:単なる「新しい OSS LLM」ではないポイント

ニュースをなぞるだけだと見落としがちですが、技術的に見るとポイントはここです。

「NVIDIA 公式リファレンス LLM」ができた意味

Nemotron 3 は、

- モデル本体(Nano 30B / Super 100B / Ultra 500B etc.)

- トレーニングレシピ

- データセット

- 推論スタック(TensorRT-LLM / Triton)

- トレーニング・チューニング基盤(NeMo)

まで含めた、“GPU ベンダー純正のフル OSS スタック” です。

これ、開発者目線では地味にデカいです。

- これまで:

- 「Llama を vLLM で回す? TensorRT-LLM で最適化? TGI でサーブ?どれが一番マシ?」

- ベストプラクティスはコミュニティとベンチ記事の寄せ集め

- これから:

- 「Nemotron 3 なら、NVIDIA 公認構成(NeMo + TensorRT-LLM + Triton)がそのままリファレンス」

ぶっちゃけ、

「NVIDIA GPU 使ってるのに、わざわざ Llama + vLLM + 独自サーブを書いてるのって、

中長期的にはあまり合理的じゃなくなってくる」可能性があります。

MoE+ロングコンテキスト=“エージェント前提”の設計

Nemotron 3 は ハイブリッド MoE(Mixture-of-Experts) と

最大 100万トークンのロングコンテキストをウリにしています。

この組み合わせ、完全に「チャットボット」ではなく エージェント前提 の設計です。

- 大量ドキュメントを参照する RAG

- サブエージェントが複数ステップで API コール/コード実行

- 長時間のセッションで状態を持つワークフロー

正直、こういうワークロードは OpenAI o 系列 + ベクトル DB + ツール呼び出し で回してる人が多いと思いますが、

- モデルも OSS

- 推論スタックも OSS

- データも自前 or OSS

で組める選択肢が、ようやく “NVIDIA 純正ルート”として一本通った感じです。

競合視点で見るともっと面白い:一番ダメージを受けるのは誰か?

Meta(Llama 系)は、かなり痛い

記事にもある通り、2025 年に入ってからの Llama の存在感はかなり怪しくなっています。

- LMArena のトップ 100 から Llama が消えた

- Llama 4 は微妙な評価

- 「Avocado」はクローズド寄りになる可能性

- Menlo Ventures のレポートでも「OSS 利用減少の原因に Llama 停滞」が名指し

そこに、

「Llama の代わりに、NVIDIA 純正 OSS LLM ありますよ」

と Nemotron 3 を差し込んできたのは、かなり露骨です。

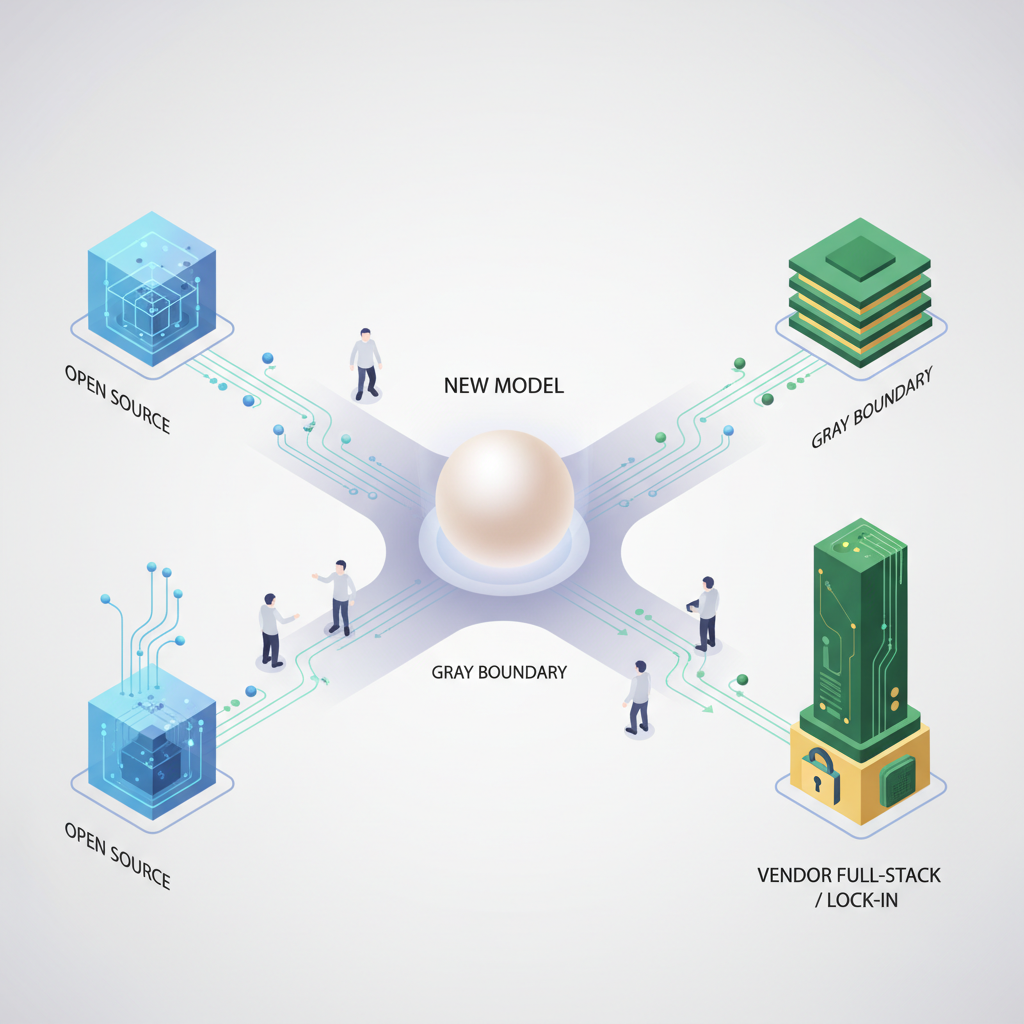

- これまで:

- 「OSS LLM 使いたい → まあ Llama 系でしょ」

- これから:

- 「NVIDIA GPU 前提 → Llama or Nemotron 3? どっちが“将来性”ある?」

という問いに変わります。

正直、“オープン”路線を揺らし始めた Meta と、

“OSS LLM を前面に出し始めた” NVIDIA を比べたとき、

どちらに賭けるか? と聞かれたら、企業はかなり悩むはずです。

Llama 3/4 vs Nemotron 3:ポジションの違い

ざっくり整理すると、こんな住み分けになっていくと思っています。

- Llama 系

- ベンダーニュートラル

- いろんな推論スタック(vLLM, TGI, Ollama…)が最優先でサポート

-

ただし Meta の戦略次第でライセンス・開発速度がブレる懸念

-

Nemotron 3

- NVIDIA GPU では最適化された“公式解”

- NeMo / TensorRT-LLM / Triton まで一気通貫

- その代わり、NVIDIA 依存は一段と強くなる

つまり:

Llama 3 = 「OSS LLM の汎用標準」

Nemotron 3 = 「NVIDIA GPU 向けの最適化リファレンス LLM」

という構図です。

「ぶっちゃけ助かる」ポイント:開発者にとってのメリット

「とりあえず Llama」で悩まなくていい世界線

新規に OSS LLM を選ぶとき、いままでは

「Llama 一択だけど、ライセンスと将来がちょっと不安なんだよな…」

とモヤモヤしながら採用していた組織は多いはずです。

NVIDIA GPU 前提の現場だと、これからは

- 「Nemotron 3 をデフォルト候補としてまず試す」

- ダメなら Llama / Gemma / Qwen / DeepSeek に逃げる

という逆順の検討フローも十分あり得ます。

特に、

- すでに Triton でサービングしている

- NeMo ベースでファインチューニング基盤を作っている

といった組織にとっては、

「一番実装コストが低い OSS LLM」 になりうるのが Nemotron 3 です。

「小さくて速い」Nano 系はローカル勢には素直にうれしい

コミュニティでも話題ですが、Nemotron 3 Nano / Nano 2 のような小型モデルは、

- 8〜12GB VRAM のちょい古 GPU

- 16GB~32GB RAM のワークステーション

- あるいはそこそこのノート PC

でも現実的に動かせるサイズ感です。

しかも NVIDIA 自身が

- SFT / RLHF 前提

- スキルギャップを見つけてコミュニティで改良していく

という文脈で語っているので、

「自作ツール+軽量 LLM」のローカル環境を作る人にとってはかなりおいしいポジションです。

ただし、“いい話”だけではない:隠れた落とし穴

ここからが本題です。

Nemotron 3 は魅力的ですが、「これで全部解決!」とは全然思っていません。

「OSS だけどロックイン」という二重構造

最大のポイントはここです。

モデルはオープン。

でも、最適なパフォーマンスを出したいなら NVIDIA スタック一択。

つまり、

- GPU:NVIDIA(H100, Blackwell, RTX…)

- ランタイム:CUDA / cuDNN

- 推論:TensorRT-LLM / Triton

- トレーニング:NeMo

という構成が、事実上の前提条件 になっていきます。

結果として:

- モデル選択の自由度は増える

- でもインフラレイヤーでの NVIDIA ロックインはむしろ強くなる

という矛盾した状態が生まれます。

正直、

「クラウド料金が上がっても、NVIDIA のロードマップが変わっても、

逃げづらくなる未来」が見えるのは、エンタープライズとしては無視できません。

コスト構造は全然“安くなってない”

「OSS LLM だからコストダウン!」と思いたくなりますが、

残念ながら現実はそんなに甘くありません。

- GPU は結局高い(むしろブラックウェル世代はさらに高価)

- ロングコンテキスト(100万トークン)は、メモリも計算量も重い

- MoE は賢いけど、実装・運用はそれなりに複雑

Nemotron 3 の「最適構成」がハイエンド GPU を前提に設計されているなら、

中小規模の組織にとっての敷居はむしろ上がる 可能性すらあります。

「オープンソース」の中身は、ちゃんと確認した方がいい

コミュニティでも出ている懸念ですが、

- 本当に “商用利用・再配布可” なのか

- 研究用ライセンス+厳しい利用規約、というパターンじゃないのか

- すべてのバリアント(Nano / Super / Ultra)が同じ条件なのか

ここはリポジトリをちゃんと読むしかありません。

正直、最近の「半オープン」「準オープン」モデル乱立の中で、

“オープンソース”の一言だけでは信用できない 時代になっていると思っています。

Nemotron 3 も、プロダクション前提なら 法務とセットで精読必須 です。

コミュニティ・ツールエコシステムは、まだ Llama の勝ち

Llama 系は、なんだかんだで

- vLLM

- TGI

- Ollama

- 各種エージェントフレームワーク

あらゆる OSS が最初にサポートしに行く「デフォルト」の座をまだ維持しています。

Nemotron 3 は NVIDIA 製という強みがある一方で、

- 初期は TensorRT-LLM / Triton / NeMo 偏重

- vLLM や汎用エコシステム側の最適化はこれから

- ノウハウ・事例・トラブルシュート記事が圧倒的に少ない

という状態からのスタートです。

最初の採用者ほど、ベストプラクティスを自分たちで切り開く負荷 を負うことになります。

そこを楽しめるかどうかで、向き不向きが分かれそうです。

プロダクションで使うか?正直まだ「用途しだいで限定的に」くらい

では、エンジニアとして Nemotron 3 を本番で使うか?という話。

今の自分の結論はこんな感じです。

即プロダクション採用「アリ」だと思うケース

- すでに NVIDIA スタック(NeMo / Triton / TensorRT-LLM)をがっつり使っている

- GPU もクラウドも、NVIDIA ロックインはもはや受け入れている

- エージェントワークフロー(RAG / ツール呼び出し / マルチステップ推論)がメイン用途

- Llama の将来に不安があり、OSS 路線の“別軸”を確保したい

こういう組織にとっては、Nemotron 3 を「第 1 候補」として検証する価値はかなり高いです。

正直まだ「様子見」でいいケース

- ベンダーニュートラルな構成を最優先したい

- すでに Llama / Gemma / Qwen / DeepSeek ベースでパイプラインができあがっている

- vLLM / TGI / Ollama など汎用スタック中心でやっていきたい

- 法務観点でライセンスの透明性を特に重視している

このあたりのチームは、

- まずローカルや検証環境で Nemotron 3 Nano / Super を触ってみる

- Llama / Gemma に対して、品質とコストがどのくらい変わるかを実測

- コミュニティのベンチ・事例がもう少し出そろうまで待つ

くらいの距離感がちょうどいいと思います。

最後に:Nemotron 3 は「オープンソース LLM の主役交代」の始まりかもしれない

Nemotron 3 の登場は、

- Meta が握っていた OSS LLM の“事実上の標準”の座

- NVIDIA が狙う「ハード+ソフト+モデル」フルスタック支配

この2つのラインが交差した地点にあります。

正直、これが「完全な善」だとは思いません。

むしろ、NVIDIA という超巨大プレイヤーへの依存はさらに深まります。

ただ、開発者目線で見ると、

- Llama 依存からの“もう一つの逃げ道”

- エージェント前提に設計された OSS LLM

- GPU ベンダー純正の最適化フルスタック

という 3 点は、無視できないほど魅力的です。

「オープン」と「ロックイン」の境界線がますますグレーになる時代 に、

Nemotron 3 をどう位置づけるか。

- 「NVIDIA に全振りする覚悟」を決めるのか

- それとも、Llama や他の OSS と組み合わせて “マルチ OSS LLM 戦略” でいくのか

各チームが、

技術だけでなくビジネス的な覚悟も含めて選択を迫られるフェーズに入った──

Nemotron 3 は、そういう“合図”だと感じています。

あなたのプロジェクトでは、

次の OSS LLM 候補リストに Nemotron 3 を入れますか?それとも、まだ外しておきますか?👀

コメント