「PoCまではサクッとできるのに、そこから先で急にビジネスとして詰むんだよな……」

生成AIを触っているエンジニアなら、一度はこう感じたことがあると思います。

そんな中で飛び込んできたのが「OpenAI、利益率70%水準に到達」という話。

正直、この数字を見て、最初に出てきた感情は「すげえ」よりも「え、そんなに儲かってる側と、全然儲かってない側の落差エグくない?」でした 🤔

この記事ではニュースをなぞるのではなく、

- なぜOpenAIは70%も利益を出せるのか

- その一方で、なぜ我々のAIプロジェクトの95%は赤字っぽいのか

- 開発者・スタートアップ・企業は、この構造を前提にどう戦略を変えるべきか

を、「AWS初期」とのアナロジーを交えながら、かなり主観多めで整理してみます。

一言でいうと:AI界の「AWS初期」が始まった

一言で言うと、今回の利益率70%って、

「AI界のAWS 2008年フェーズに、OpenAIが先に到達した」

という話だと感じています。

- 一度巨大なインフラ(今回はGPUクラスタ)にドカンと投資

- その上で「汎用リソース」(今回は汎用推論能力)をAPIとして提供

- 利用者が増えるほど、限界費用は電気代+減価償却レベルに近づき、

それなのに価格はSaaS水準で維持できる

この構図、AWSのEC2/S3が爆伸びしてた頃とほぼ同じです。

違うのは、「コンピュートやストレージ」は完全なコモディティになったのに対して、

「LLMの推論能力」はまだ明確な差別化要因になっていること。

ここがややこしく、そして厄介なポイントです。

なぜ70%利益率まで行けたのか:技術の話ではなく「構造」の話

まず、「そんなに儲かるほど高く売ってるのか?」という話になりがちですが、

本質は価格というより構造です。

一度作ったモデルは「ほぼSaaS」

- 学習コスト:巨大だけど一括投資で、のちのち償却

- 推論コスト:GPU・電気代・減価償却。スケールすればするほど1リクエストあたりは逓減

- 収益:ChatGPT有料版・API利用料という反復課金

一度「よく回る大規模モデル+巨大GPUクラスター」が立ち上がると、

追加ユーザーが増えても、利益率がほとんど落ちない

=インフラSaaSと同じ“夢の構造”

に近づきます。

技術的には「推論コストがまだ高いニッチ技術」じゃなくて、

すでにクラウドSaaS級の収益性に到達した、というのが今回の一番のポイントだと感じます。

「コストは劇的に下がるのに、価格はゆっくりしか下がらない」世界

GPU最適化やモデル改良が進めば、推論コストそのものは着実に下がります。

でも、ユーザから見た価格はどうかというと……

70%利益率を見ればわかる通り、

- 今の価格でも十分に需要がある

- 競合が一気に価格破壊しているわけでもない

つまり、当面は「コストは大きく下がるのに、値段はそこまで下がらない」世界が続く可能性が高い。

ぶっちゃけ、

「そのうちAPI料金なんてタダ同然になるっしょ。今は我慢」

という前提で事業設計してると、かなり危険です。

「真の勝者はどこか?」を冷静に分解する

よくある議論は「NVIDIAが一番儲かる」「OpenAIが勝者だ」「いやアプリ層が勝つ」みたいな話ですが、

利益率70%という数字が出てきた今、構造的にどこがどう美味しいのかを整理してみます。

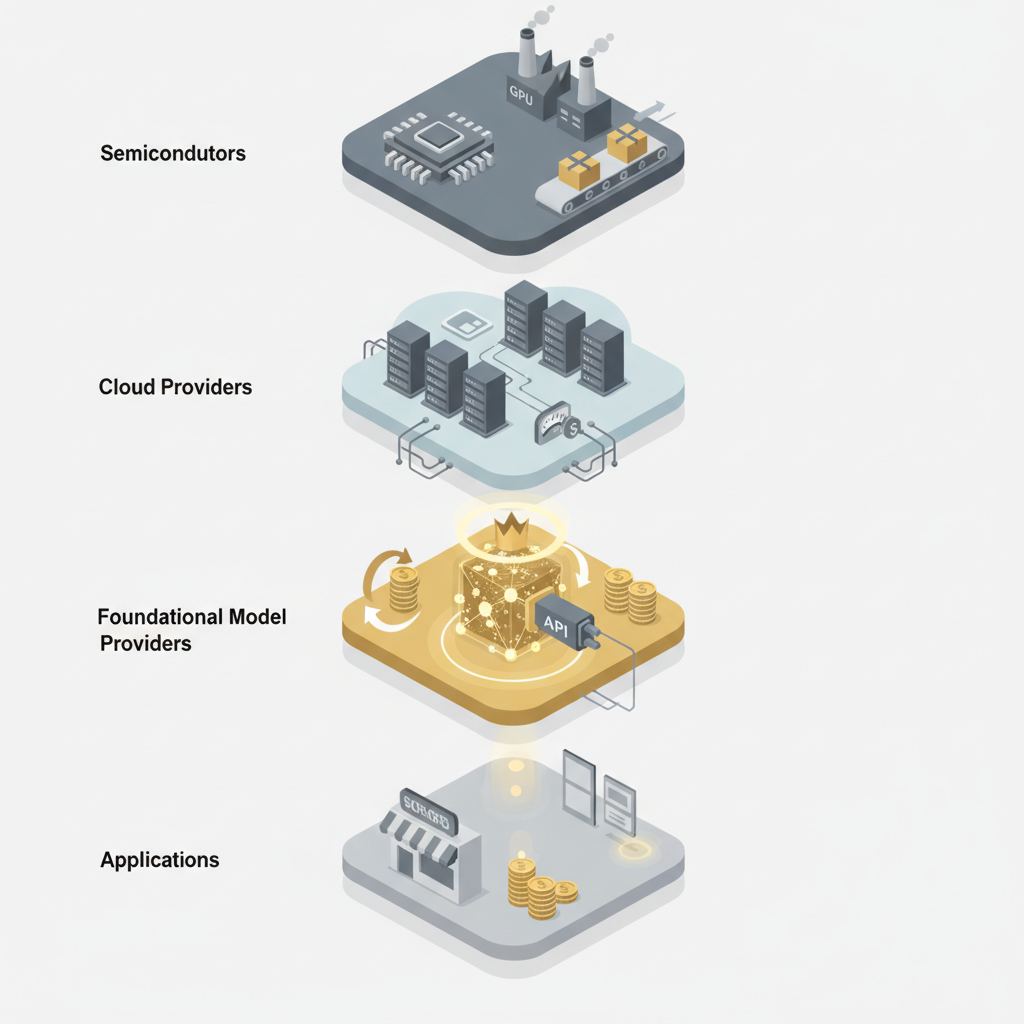

レイヤー別ざっくり整理

- 半導体(NVIDIAなど)

- GPU自体は「売ったら終わり」型が基本(+クラウド向けの継続販売)

-

需給タイトな間は超高収益だが、長期的には設備産業寄りになるリスクも

-

クラウド(Azureなど)

- GPUを抱えつつ、AI向けコンピュートとして貸し出し

-

ここもスケールすれば高収益

-

基盤モデルプロバイダ(OpenAIなど)

- GPUとモデルをAPIという形でパッケージング

-

一度作ったモデルを何度も使い回せる

→ ここが最もSaaSっぽい構造で利益率を取りやすい -

アプリケーションレイヤー(スタートアップ含む)

- OpenAI APIを買って、自社顧客に売る「卸+小売」モデル

- ここが一番マージンが圧迫されやすい

利益率70%は、3の「基盤モデル」レイヤーが思っていた以上に“おいしいポジション”だと証明したわけです。

GoogleやAnthropicと比べると、何がエグいのか

OpenAI vs Anthropic:スケールの正のフィードバック

Anthropicも似た構造で収益を上げているはずですが、

OpenAIの70%が示すのは、単なる“儲かってる”以上に、

高マージン → R&D・GPU確保・モデル改善に再投資

→ モデルがさらに強くなる → ユーザが増える → さらにスケールメリット

という正のフィードバックループにガッツリ乗っている、という事実です。

Anthropicは、

- 安全性・企業向け・Constitutional AI などで差別化している

- しかしOpenAIもそこに本気で投資し始めると、差別化が侵食されやすい

構造的にはかなりしんどいポジションに追い込まれやすいです。

Google・Metaなどの「内製型」との違い

GoogleやMetaは自社サービス内にモデルを組み込む「内製型」なので、

外向きの「利益率70%」みたいな数字は表に出にくいですが、

- 自社プロダクト群の中でAIをどう価格転嫁するか

- 広告や検索のビジネスモデルとどう整合させるか

という制約を抱えています。

それに対してOpenAIは、

- 「モデルを売る」こと自体がビジネス

- 純粋にAPIとサブスクの設計に集中できる

ので、マージン設計において圧倒的に自由度が高い。

ここが「外販AI専業」企業の強さであり、同時にエコシステム的には怖いところです。

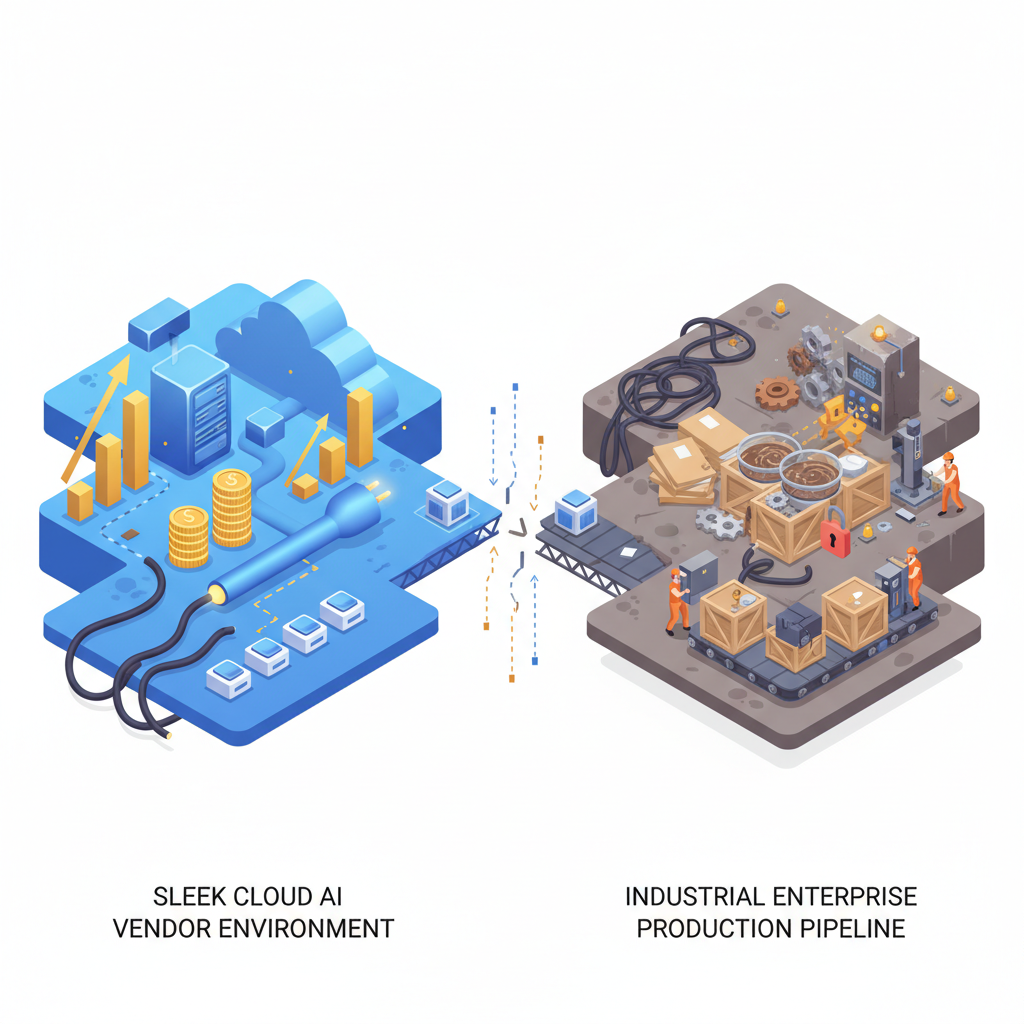

現場とのギャップ:AIプロジェクト95%はまだ儲かってない

一方でコミュニティの空気はかなり冷めています。

MITの研究で「企業のAIイニシアチブの95%はまだ利益を出せていない」という話が引用されまくっている通り、

「ベンダーだけが太っていて、ユーザー企業側は全然ペイしてないのでは?」

という不信感がかなり強い。

何がボトルネックなのか?

正直、これは「OpenAIのせい」というより、構造的な問題が大きいです。

- PoCまでは簡単にできる(API叩けばそれっぽいものは動く)

- でも本番運用に上げるには:

- データ整備

- ワークフロー設計

- セキュリティ・コンプラ

- オペレーション変更・教育

…など、“泥臭いところ”を全部やり切る必要がある

AIベンダー側の利益率70%は、

ある意味「PoCを量産させるビジネスモデル」としての成功の裏返しでもあります。

PoCを作るのはものすごく安く・速くなった

→ でも「本当に事業に効く変更」ができていない

→ ROIは出ない、しかしAPI利用は増える

→ ベンダーの売上と利益は伸びる

という、ちょっと歪んだ構図です。

「もう仕事奪ってるじゃん」 vs 「仕事の質が変わるだけ」

コミュニティを見ていると、雇用の話もかなり出ています。

- CS、ライティング、コーディング補助などで

「人を増やさずにAIで回している」という報告は確かに増えている - その一方で、

- 同じ人数で2〜3倍の案件を回せるようになった

- 夜間・休日対応をAIに任せて、人間は難しい案件に集中

という事例も出てきている

個人的には、

「短期的には“増員抑制+効率化”の圧力が強く出る」

「中長期的には“仕事の質の変化”が本格化する」

という二段階で進むと見ています。

ただ、ここで効いてくるのもやっぱり利益率70%なんですよね。

ベンダー側がこんなに高利益率を出せる構造である限り、

- 企業側は「人を減らさずに効率化」の美しいストーリーより

- 「コスト削減」の方に引っ張られやすい

という現実的なインセンティブが働きます。

本題の「Gotcha」:この70%が開発者にとって何を意味するか

ここからが、エンジニア・スタートアップ目線で一番重要な話です。

価格の“天井”は高いままかもしれない

70%利益率=「今の価格でも市場は普通に受け入れている」という意味です。

- コストが下がっても、その分が価格にすぐ転嫁されるとは限らない

- 競合が価格破壊を仕掛けない限り、

ベンダーマージンが高止まりしたまま数年続いてもおかしくない

なので、

「数年後にはAPIコストが10分の1〜100分の1になっている前提」

でビジネスモデルを組むのは、正直ギャンブルに近いと思っています。

結論:今の価格でも黒字になるユニットエコノミクスで設計するべきです。

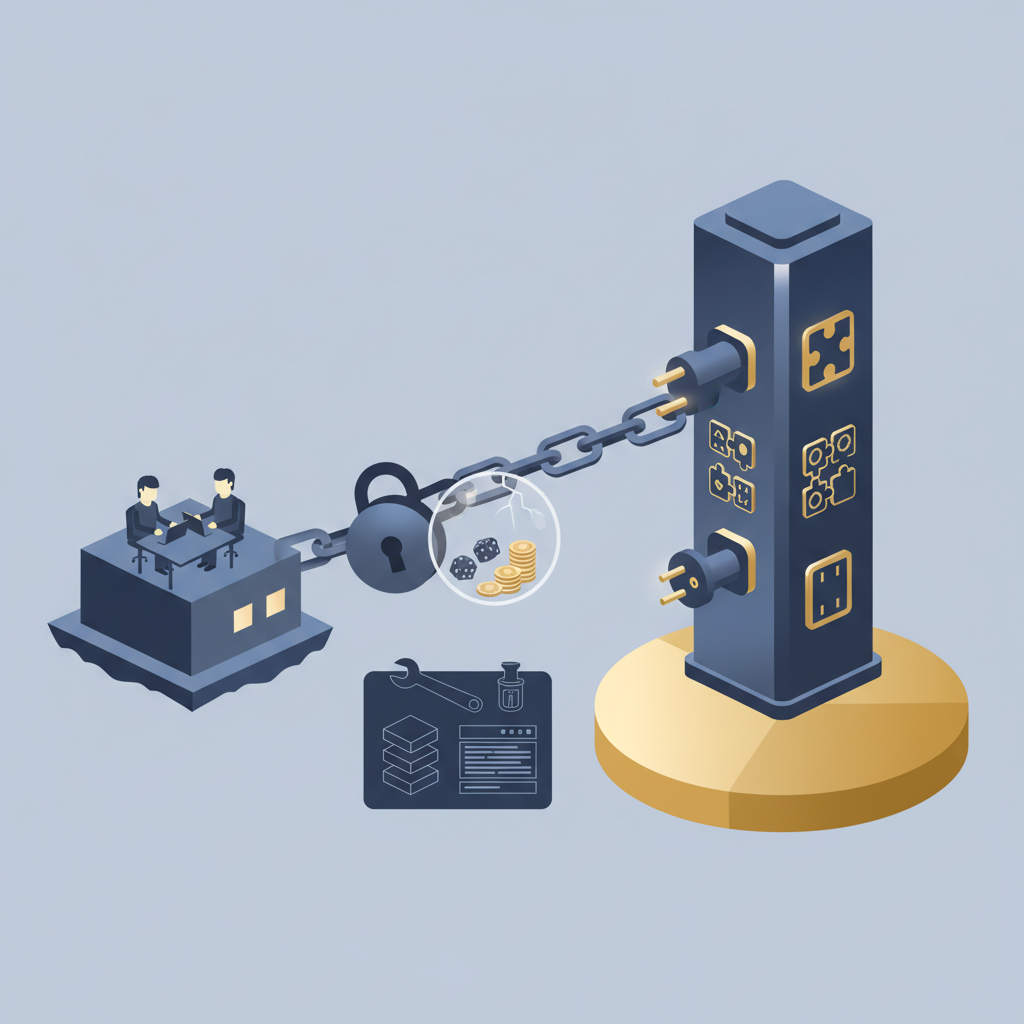

ベンダーロックインの実効コストがエグくなり得る

利益率が高いビジネスは、ほぼ確実に囲い込みに走ります。

技術的にも:

- プロンプトフォーマット

- ツール呼び出し仕様

- ガードレール設定

- ログ・監査の仕組み

- 専用のベクターストアやエージェントフレームワーク

などが、ベンダー固有仕様としてどんどん積み上がる。

その上にアプリケーションを最適化してしまうと、

乗り換え=ほぼフルリプレイス+再チューニング

という状態になりやすいです。

クラウド初期に「AWSから抜けられない」問題を経験した人なら、あの再来だと思ってもらえば近いです。

対策としては:

- 可能なら最初からマルチモデル対応の抽象レイヤーを挟む

- プロンプト・ツール定義を、ベンダー非依存な形で管理する

- 依存を「一社のSDK」ではなく、「自前の薄いアダプタ」に閉じ込める

このあたりを最初のアーキテクチャ設計時に仕込んでおくかどうかが、

2〜3年後の自由度に直結すると思います。

コモディティ化するのは「モデル」ではなく「周辺ツール」だけかもしれない

「LLMはすぐコモディティ化して、安くなる」という楽観論もありますが、

少なくとも利益率70%が続いている間は、APIそのものは簡単にはコモディティ化しないとみるべきです。

代わりにコモディティ化しそうなのは、

- プロンプトオーケストレーション

- マルチエージェント制御

- ベクターストア統合

- RAGの組み立てフレームワーク

といったミドルウェア層です。

ここはOSSやサードパーティがどんどん出てきて、価格競争・差別化競争になるはず。

ぶっちゃけ、

「OpenAI APIに薄いラッパーを被せただけのSaaS」

は、長期的には生き残りにくい構造です。

上位レイヤー(OpenAI本体)が同じ機能を出した瞬間に、上位互換化されてしまうので。

じゃあ、どこで戦えばいいのか?

悲観的な話ばかりしても仕方ないので、

70%利益率の世界で我々がどこを攻めるべきかも整理します。

開発者・スタートアップが狙うべきポジション

- 業界特化・業務特化の深堀り

- 特定業界の業務フロー・文化・データに深く入り込む

- 「AI+業務改革」を丸ごとパッケージできるところまでやる

- 独自データ・独自フィードバックループ

- モデルそのものはOpenAIでも、

学習・評価・フィードバックのループは自社固有にする - オンプレ・ローカル・規制対応

- 金融・医療・公共など、クラウド前提では入りにくい領域で

オープンモデルやローカル推論とのハイブリッドを組む

この辺りは、OpenAIも簡単には踏み込みづらい「泥臭い領域」です。

ここに踏み込んでいけるチームだけが、基盤モデル70%利益率時代にもちゃんと取り分を持てると感じます。

企業側の「勝ちパターン」はすでに見え始めている

MITの「5%だけ成功している企業」の話ともリンクしますが、

うまくいっている企業には共通パターンがあります:

- 派手なチャットボットより、

バックオフィスのワークフロー自動化・ナレッジ検索最適化を優先 - 「AI単体」ではなく、既存システム・RPA・プロセス改善と組み合わせる

- 小さなユースケースでROIを出しながら、段階的に拡大

要するに、

「OpenAIの高性能を、地味な業務改善にひたすら突っ込む」

というスタンスが、一番リターンを出しやすい。

ここに腹を括れるかどうかが、企業側の分かれ目だと思います。

結論:プロダクションでどうするか?正直、「楽観前提」は全部捨てた方がいい

最後に、自分ならどうするかをはっきり書いておきます。

プロダクションで使うか?

使います。むしろ積極的に使うべきだと思っています。

品質・安定性・エコシステムを総合すると、現時点でOpenAIを避ける合理的な理由はほぼありません。

ただし、その前提は:

- マルチモデル切り替え前提の設計

- 今の価格でも黒字が出るビジネスモデル

- 「薄いラッパーSaaS」はやらない

の3つです。

正直な本音

正直に言うと、「そのうちAI APIはタダみたいになるから、今は赤字でもシェアを取ればOK」みたいな発想は、

70%利益率という数字を見た瞬間に、かなり危険シグナルに変わりました。

- ベンダーのコストは確実に下がる

- でも、その分のほとんどはベンダーの利益として吸収される可能性が高い

- 我々ユーザー・開発者側に落ちてくるのは、価格ではなく

- モデル品質の向上

- ツール・エコシステムの充実

- 新しい抽象化レイヤー

の方かもしれない。

だからこそ、

「安くなる未来」に賭けるのではなく、

「今の前提でどう勝ちに行くか」を設計する

というマインドセットに、早めに切り替えた方がいいと感じています。

まとめ

- OpenAIの利益率70%は、「AIクラウドがAWS初期フェーズに入った」ことのサイン

- コストは下がるが、価格が同じスピードで下がるとは限らない

- PoC量産モデルの裏で、現場の95%はまだROIを出せていない

- 「ロックイン」「マージンの高止まり」「真の勝者は基盤レイヤー」という構造を前提に、

- マルチモデル前提アーキテクチャ

- 今の価格でも黒字になるビジネスモデル

- 業務・業界への深い入り込み

を、最初から設計に組み込むべきです。

ぶっちゃけ、

「そのうち安くなるから今は気にしない」は、もう通用しないフェーズに来ています。

OpenAIが70%の利益率で走り始めた今、我々も「楽観」ではなく「構造理解」を武器に、次の一手を考える必要があると思います。

コメント