「Hey Siri、○○して」って言ったのに、

「すみません、よくわかりません」──これ、何回聞かされましたか?

運転中にルート変更を頼んでも噛み合わない。

リマインダーを頼んだのに、なぜか違うリストが増えている。

開発者としては「こんなアシスタントに自分のアプリの入り口を任せたくない…」と感じた人も多いはずです。

そんなSiriのバックエンドに、ついにGoogle Geminiが入ってきます。

AppleとGoogleが複数年のAI提携、次世代SiriやApple Intelligenceの基盤としてGemini採用──これはただのニュースではなく、iOSの“AIレイヤー”の設計思想がひっくり返る話です。

この記事では、単なる「Siriが賢くなります」ではなく、

- これがなぜ歴史的な動きなのか

- 開発者にとって何がチャンスで、何がリスクか

- ぶっちゃけ、これ乗るべきか、まだ様子見るべきか

を、エンジニア目線+ちょっと辛口で整理します。

一言でいうと:モバイル界の「iPhone×Google検索」+「Windows×Azure」再来

今回の提携、インパクトを一言でたとえるなら、

「初代iPhoneがデフォルト検索をGoogleにした瞬間」と

「Windowsがクラウド時代にAzureとガッツリ一体化した瞬間」を足して2で割ったような出来事

です。

- 2007年:Safariの検索窓の“頭脳”をGoogleに任せた

- 2026年:SiriとApple Intelligenceの“頭脳”の一部をGoogle Geminiに任せる

違うのはレイヤーの深さ。

- 以前:ブラウザの検索エンジンとしてGoogle

- 今回:OSレベルのAIアシスタント/UIインターフェースの中核としてGoogle

UIそのものが「自然言語+生成AIファースト」になっていくタイミングで、その“脳”を外部ベンダーに預ける。

正直、Appleがここまで踏み込むとは数年前なら誰も予想してなかったはずです 🤔

正直ここが一番デカい:Siriの“アーキテクチャが世代交代”する

ニュースの見出しだけ見ると「SiriがGeminiで賢くなります」程度に思えますが、

技術的にはもっと根っこから変わります。

Siriの裏側が「二層構造AI」になる

ざっくりいうと、次世代Siriはこうなりそうです:

- オンデバイス層:Apple独自モデル

- Apple Silicon+Neural Engine上で動くローカルLLM

-

デバイス操作や短い応答、プライバシーがシビアな処理を担当

-

クラウド層:Google Gemini

- 長文生成・高度な推論・Web検索・マルチモーダル

- 「World Knowledge Answers」みたいな、広い知識を使う応答

ユーザーから見ると、

- 「ちょっとした操作」→ ローカルでサクッと

- 「込み入った相談・調査・要約」→ こっそりGeminiにオフロード

というハイブリッドな動きになります。

ぶっちゃけ、これはSiriの推論エンジンを総取っ替えするレベルの話で、

Siriを「ルールベース+ちょいNLPのコマンドUI」と見ていた時代は完全に終わります。

なぜAppleはここまでしてGeminiを採用するのか

自前AIだけでは、もはや追いつけない

Apple自身の言い方だと:

GoogleのAIが、Apple Foundation Modelsにとって「最も優れたプラットフォーム」

とまで言ってしまっている。

要するに、

- 巨大LLMをクラウドでグローバル展開

- マルチモーダル・長コンテキスト・強めの推論

- それを数億ユーザー分スケールさせる

この辺の「クラウド大規模モデル運用力」で、AppleはGoogleに敵わないと認めたようなものです。

開発者視点で言い換えると:

「巨大LLMの運用はGCPに丸投げして、

その上でApple独自の体験レイヤー(Siri/Apple Intelligence)をかぶせる」

というアーキテクチャ判断。

クラウド時代にMicrosoftがAzureと心中したのと、かなり構図が近いです。

ユーザーがすでに「ChatGPT水準」を知ってしまった

さらに厄介なのは、ユーザーがもうChatGPTやGeminiのUI/品質に慣れてしまったこと。

- 「Siri、●●について要約して」→「それはよくわかりません」

- 一方で、ChatGPTやGeminiアプリを開けば即座に自然な要約

このギャップを数年放置した結果、

- 「Siri=不便なショートカットランチャ」

- 「生成AI=ChatGPTやGemini」

という役割分担が、ユーザーの頭の中で固まってしまいました。

ここをひっくり返すには、Siri側がフルスケールLLMレベルに一気にジャンプする必要があり、

Appleが「自前で全部やる」だけでは、もはや時間的に間に合わない…という判断なのでしょう。

これ、誰にとって一番やばいのか?(競合分析)

一番キツいのはOpenAI+Microsoft陣営

iOSというプラットフォームで「標準の自然言語インターフェース」が、

- アイコンタップ → ChatGPTアプリ

ではなく、 - 「Hey Siri」→ 裏でGemini

になってしまう。

これは、

- デフォルト検索がBingではなくずっとGoogle

- デフォルトブラウザがEdgeではなくSafari/Chrome

と同じ構図で、「入口を握っている側が勝つ」パターンに入ります。

ChatGPTやCopilotはアプリとしては残るにしても、

- ユーザーは「とりあえずSiriに話す」

- それで大抵のことは済んでしまう

- わざわざ別アプリを開くのは「特殊な用途」「企業向け」になっていく

という未来がかなり現実的になりました。

サードパーティAIアプリは「検索窓アプリ化」リスク

ClaudeやPerplexity、その他LLMラッパーアプリも同じです。

- これまでは「iPhoneの中のChatGPT」として存在感があった

- でもSiriが同等以上に賢くなり、

- しかもOSの設定・電話・メッセージ・ショートカットと深く統合される

となると、単独アプリの存在感はかなり希薄になる可能性があります。

極端に言えば、

昔:専用の検索アプリを入れていた

今:ブラウザのURLバーから全部やる

と同じことが、

今後:専用のチャットAIアプリではなく、「Siriの一声」ですべて済む

という方向にシフトしていくかもしれません。

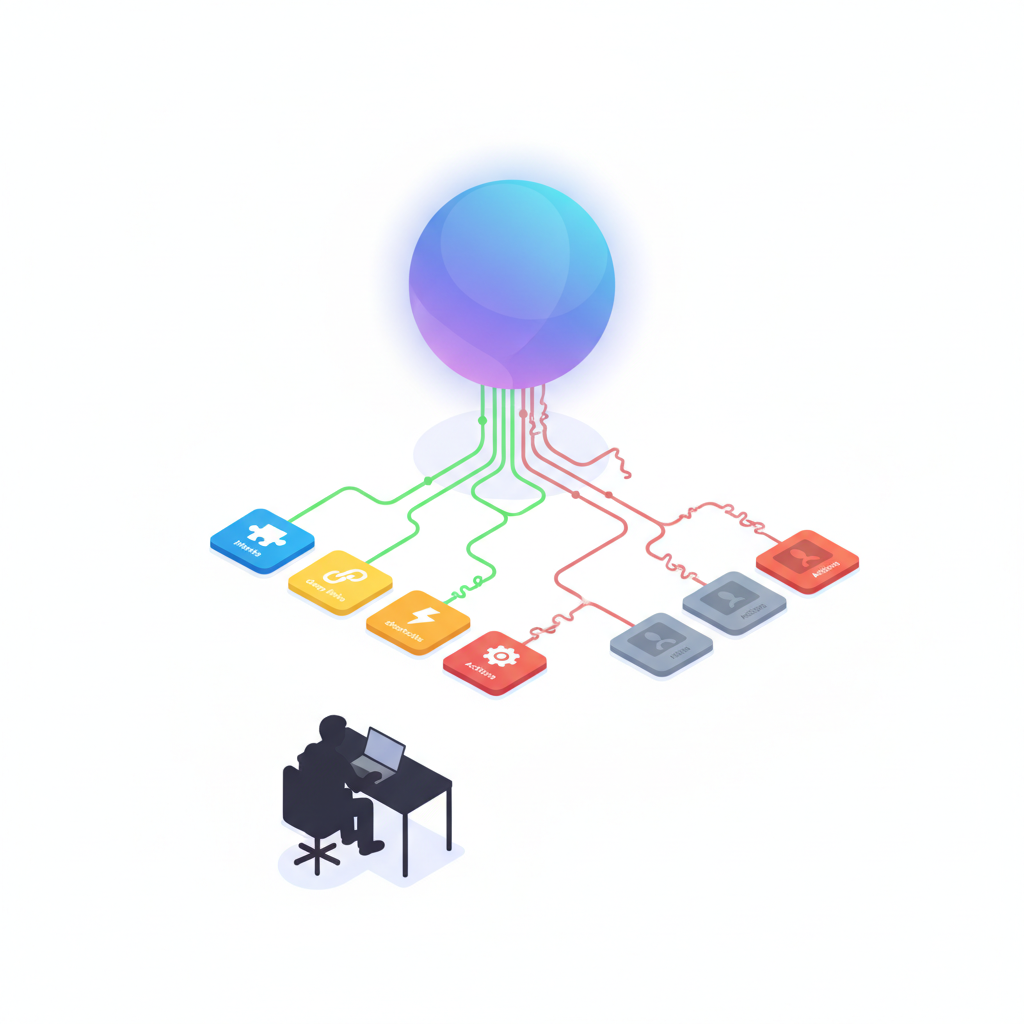

Dev目線での“本当のキモ”:「Siri経由でアプリが使われる」世界

ここで開発者にとって重要なのは、

これからのiOSアプリは「Siriにどう呼び出されるか」設計しないと、

単にホーム画面の1アイコンとして埋もれていく

という点です。

SiriKit / App Intents の重要性が一気に上がる

GeminiがSiriの裏側で賢くなったとしても、

結局ユーザーの具体的なアクションは、アプリに委ねられます。

例:

- 「明日の10時に◯◯さんとミーティング入れて」

- 「このPDF、チームに共有して要点まとめて」

こういう指示を、

- うまく自分のアプリの機能にマッピングできるか?

- App Intents や Shortcuts で「呼び出し可能なアクション」として宣言してあるか?

ここで差がつきます。

Geminiが賢くなるほど、「どのアプリにルーティングするか」の選択が重要になるので、

- Intent定義がしょぼいアプリ

- Deep Linkが整理されていないアプリ

- ショートカット対応が雑なアプリ

は、自然言語UI経由でほぼ呼ばれないアプリになりかねません。

正直、「画面UIだけきれいに作ってればOK」という時代は終わりつつあります 🚨

ただし…デメリットもかなりデカい

ベンダーロックインの“二重構造”

今回の構図はこうです:

- 表側:AppleのAI抽象レイヤー(Siri / Apple Intelligence / 新API群)

- 裏側:Google Gemini(クラウドLLM)

開発者としては、

- Appleが公開するAPIに最適化するしかない

- その裏でどのモデル(Gemini Pro/Flash/将来の別モデル)が使われるかはコントロールできない

- 応答のポリシーや制限も、Apple+Googleの黒箱の中

という、なかなかヘビーなロックイン構造になります。

「Geminiを使っているのに、Geminiを直接コントロールできない」

という、ちょっとモヤっとする状態です。

レイテンシ・可用性・リージョンの三重苦リスク

クラウドLLMをOSレベルの体験に組み込む以上、

- 回線が遅い/不安定 → Siriの一部機能が激重 or 使えない

- Google側の障害 → OS標準機能の一部が巻き添え

- 地域規制(EU/中国/その他) → 国によってSiriの賢さに差が出る

という問題が必ず出ます。

「一部地域だけSiriが“旧世代のバカさ”に戻る」みたいな体験の断絶が起きる可能性は、かなり現実的です。

ユーザーからは単に「Siriの気分のムラ」に見えるので、

開発者としてはデバッグも説明もめちゃくちゃ難しいパターンです。

プライバシーは本当に守れるのか問題

Appleは当然、

- 「Apple Intelligenceは引き続きオンデバイス+Private Cloud Computeで動作」

- 「プライバシー基準は維持」

と強調しています。

設計としては、

- デバイス側でPIIマスキング・前処理

- AppleのPrivate Cloudを経由

- その向こう側でGeminiが推論

みたいな三段構えにするのでしょうが、

正直、ユーザーの心理的ハードルはかなり高いと思います。

- 「Siriに話した内容がGoogleに行くのか?」

- 「どこまでがAppleの管理で、どこからがGoogleなのか?」

- 「学習には使われないのか?」

この辺りを、Appleがどこまで透明に説明できるかが鍵です。

ここをぼかしたままだと、特に企業利用・エンタープライズではかなり嫌がられるはずです。

じゃあ、開発者として今何をすればいいのか?

ぶっちゃけ、「明日から全部Gemini前提で作り替えろ」という話ではありません。

ただ、2〜3年のスパンで見たときの“UI設計のパラダイムシフト”に備えるべきです。

いますぐやるべき最低限

- 自分のアプリの主要機能を

「1文で指示できるアクション」単位にブレークダウンしておく - 例:「請求書をPDFでエクスポートして◯◯へ送る」など

- SiriKit / App Intents / Shortcuts 対応を見直し

- 「どの機能が自然言語から呼ばれうるか」を棚卸し

- プライバシーポリシーをアップデート

- 「AI連携時にどのデータがどう扱われるか」を明文化しておく

自前LLM戦略とのすみ分け

正直、“表の窓口”はSiriに任せた方がUX的に勝ちやすいです。

おすすめの分担はこんな感じ:

- 表側(ユーザーとの会話・起動トリガ):

→ Siri / Apple Intelligence 経由にフル対応 - 裏側(ドメイン特化・企業データ・独自知識):

→ 自前で OpenAI / Claude / Vertex AI 等を使って差別化

つまり、

「入口はSiri、コアの頭脳は自分で選ぶ」

というハイブリッド戦略が現実解だと思います。

ぶっちゃけ、プロダクションで全力コミットすべきか?

正直に言うと、

「Siri×Gemini前提でアーキテクチャを全部組み替える」のは、まだ様子見

が妥当だと感じています。

理由は:

- AppleがどこまでAPIを開くか不透明

- ポリシー・リージョン制約・料金モデルがまだ見えない

- 「Gemini以外のモデルに差し替える可能性」もゼロではない

一方で、

「Siri経由でアプリが呼ばれる前提で機能を設計し直す」のは、今すぐやる価値が高い

です。

- どうせ生成AIファーストなUIは避けられない

- ユーザーは「アプリを起動する」のではなく、「自然言語で頼む」側にシフトする

- その入口を握るのがSiri+Geminiになる確率はかなり高い

なので、僕のスタンスをまとめると:

- ✅ 短期(〜1年):

- App Intents / ショートカット対応を強化

- 「自然言語で起動されるアプリ」として整える

- ✅ 中期(1〜3年):

- Appleが出してくる新AIフレームワーク(Siri連携API)の仕様を要ウォッチ

- 自前LLMとのハイブリッド構成を検証

- ❌ NG:

- まだ仕様も出ていない段階で、「Gemini前提のSiri専用アプリ」みたいな賭けに全振りする

最後に:これは「Siriが賢くなるニュース」ではなく、「UIのルールが変わるニュース」

多くの報道は「SiriがついにChatGPT級になるか?」という切り口ですが、

エンジニア・プロダクト側から見ると本質はそこではありません。

- OSレベルのUIが生成AIファーストに書き換わる

- その“脳”を、Appleが自前ではなくGoogleに一部委ねる

- 我々のアプリは、その上でどう自然言語から呼ばれるか設計し直す必要がある

という、かなり大きな構造変化です。

Siriを「ちょっと気の利かない音声ショートカットランチャ」としか見ていなかったなら、

その前提はもう捨てた方がいい。

次の2〜3年で、

「アイコンをタップするUI中心のアプリ」から、

「自然言語で起動される“機能やアクション”の集合体」

へと、求められる設計が変わっていきます。

その入口が「Siri×Gemini」になる──

今回の提携は、その未来へのかなり大きな一手だと感じています。

コメント