「LLMの情報、多すぎて追えないんだけど…」って感じていませんか?

正直、僕もここ1〜2年ずっとそうです。モデル名も tier も eval も毎週アップデート、しかも「世界初」「過去最高」が乱発されるので、エンジニアとしてはどれに反応すべきか分からなくなりがちです。

でも、2025/12/29〜2026/01/04 の LLM 関連アップデートは、単なる「精度上がりました」以上の意味がある週でした。

この1週間をちゃんと噛み砕くと、

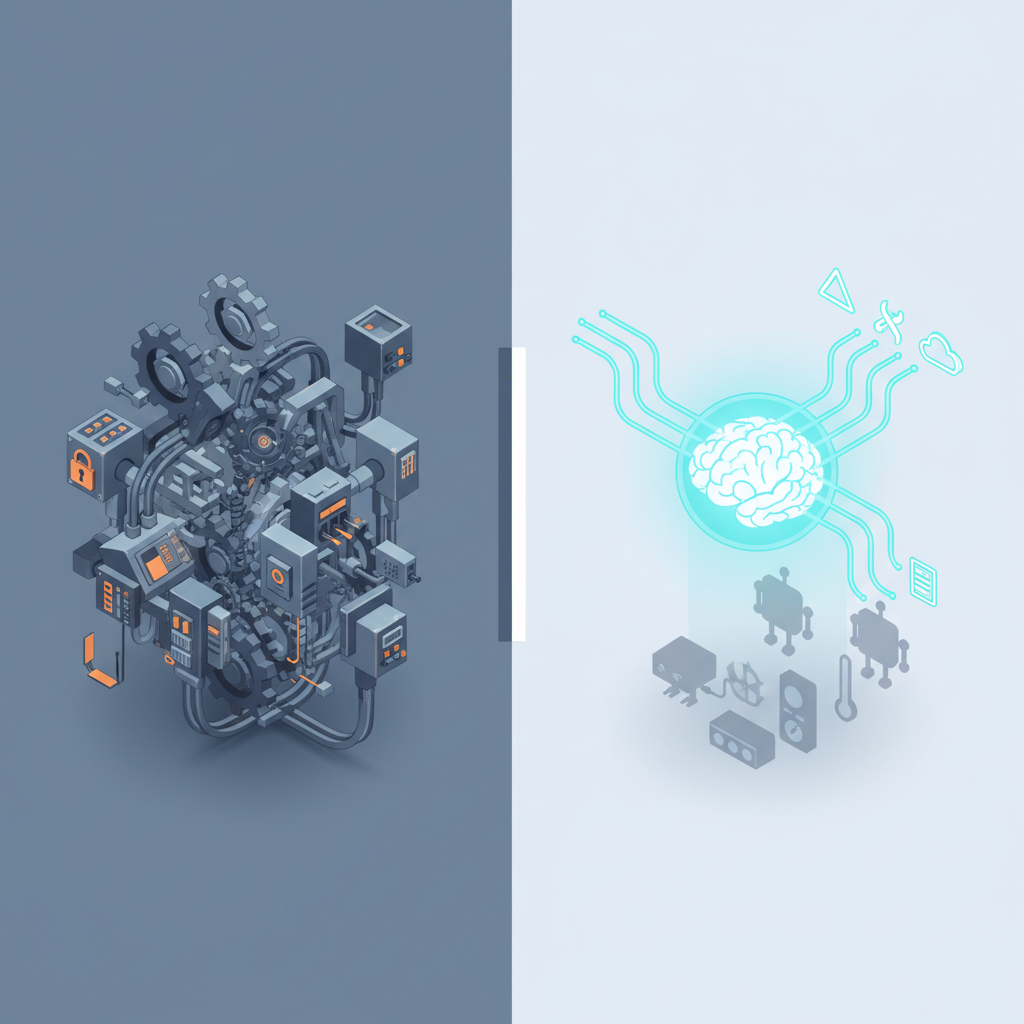

「LLMが“コンパイラ”から“常駐する運用エンジン”へと、本気でシフトし始めたターニングポイント」

だと感じています。

この記事ではニュースの羅列ではなく、実際にプロダクトを作ってきたエンジニア目線で、何が“質的に変わったのか”を整理して、どこに乗るべきでどこは疑ってかかるべきかを書きます。

一言でいうと:これは「IPython が出てきたとき」の再来

今回のアップデートを雑にまとめると、こんな構図です:

- GPT-5.2 pro が FrontierMath Tier 4 で 29.2% に到達(研究レベル数学で大きく前進)

- Claude 4.5 Opus(Opus4.5)が

- Satya Nadella の「3つの転換」をメタ要約

- まとめ記事全体の“編集長役”として使われている

- 同じ Opus4.5 を Karpathy が 「vibe coding でエアコン制御」=ほぼ Jarvis として使っている

- Nadella は 2026 年の「3つの転換」として

- アプリの作り方

- ヒューマンインターフェース

- インフラ経済

を AI 中心に再定義し始めている

これ、歴史的なアナロジーでいうと、

「バッチでしか動かないコンパイラだけの世界から、IPython / Jupyter みたいな“対話的で常駐する環境”が当たり前になった瞬間」

にけっこう近いです。

今までは「LLM でコードを一発生成して、あとは人間が運用」だったのが、

これからは「LLM がランタイムの一部として、ずっと動きながら判断し続ける」世界に、現実に足を踏み入れ始めた感じがします。

GPT-5.2 pro:これは「数字マニア向けアップデート」ではない

FrontierMath Tier 4 の 29.2% は、何がそんなにヤバいのか

「ベンチマークの数字がまたちょっと上がりました」くらいに聞こえますが、Tier 4 は研究レベル・オリンピック級数学のゾーンです。

ここで 29.2% というのは、体感として:

- 「TypeScript に型をちゃんと付けて書ける junior」から

- 「研究室の M2 がそれなりに解けるレベル」に近づきつつある

くらいのジャンプだと僕は感じています(もちろん分野差ありますが)。

ぶっちゃけ、業務で困る数学の 9割は Tier 4 より全然下なので、

- モデリング

- 最適化

- 多少の数理統計

- 軽めのアルゴリズム

あたりは、わざわざ CAS(Mathematica みたいなやつ)を噛ませなくても GPT-5.2 pro 単体でいけるケースが一気に増える可能性があります。

「じゃあ全部 GPT-5.2 pro にしよう」は危険

ただ、ここでやりがちなのが、

「5.2 pro 最強!全部 pro にするか!」

という乱暴な意思決定です。

正直これはだいぶ危ない。

理由は 3つあります:

-

コスト

pro tier はほぼ確実に高い。

数学や高難度推論がボトルネックの部分だけに絞らないと、すぐ請求が燃えます🔥 -

評価・ガードレールの崩壊

既存の 5.x 向けに - 評価指標

- ガードレール

-

プロンプト調整

を作り込んでいると、pro に変えた瞬間に挙動が変わりすぎて一度全部見直しになる可能性が高いです。 -

「強いけど暴れる」リスク

高難度推論ができるモデルほど、 - 長い推論チェーン

- クリエイティブな「抜け道」

を思いつきやすく、安全設計や制約条件の抜け穴をつきやすいという側面もあります。

僕のスタンスとしては:

- 数理/アルゴリズムがボトルネックな部分のみ

- まずは オフライン評価パイプラインだけを 5.2 pro に差し替えてみる

- 本番の inference は段階的に切り替え

くらいの慎重さでちょうどいいと思っています。

Claude 4.5 Opus が「編集長」と「執行役」を同時に取りに来ている

今回、一番おもしろいのは Claude 4.5 Opus(Opus4.5)の使われ方です。

- Nadella の長文メモの要約

- ブックマークまとめ記事全体の「メタ要約」

- Karpathy 家のエアコン制御(vibe coding)

これ、全部同じモデルでやっているのがポイントです。

「メタ要約エディタ」としての Opus

ニュースレターや技術ブログの世界で、Opus が編集長ポジションを取りに来ているのが今回よく見えました。

単なる「1記事の要約」じゃなくて、

- 複数のソースを読み込んで

- その週のトレンドの「軸」を抽出して

- Nadella の話と他の話を文脈の中で結びつける

こうなると、もはや

「LLM =クラウド上の“副編集長”」

なんですよね。

正直、これはエンジニアにとってかなりありがたい流れで、

- 週次のテックニュースのキャッチアップ

- 社内の技術情報(Confluence / Notion)のダイジェスト

- 顧客打ち合わせメモのクロスサマリ

みたいな「やりたいけど人間の脳リソースが足りない」系の仕事を、かなりいい精度で肩代わりしてくれます。

ただし、後で書きますが「それに全部乗っかる」のは危険です。

「Jarvis 的執行役」としての Opus(Karpathy の AC 制御)

もう一つ象徴的なのが、Karpathy が Opus4.5 を使って

「エアコンを vibe coding で動かしている。まさに Jarvis」

と言われている件。

ここで重要なのは、

- 単に「コードを生成」させているのではなく

- 自然言語で「こういう感じで涼しくして」「この時間帯は節電寄りで」みたいな“雰囲気”を伝え

- それを元に Opus が

- サーモスタット API を理解し

- 制御ロジックを組み

- 実際に家の環境を調整している(と推測される)

つまり、Opus がランタイムの「ポリシーエンジン」として常駐しているわけです。

これはもはや「コード生成ツール」ではなく、

「人間の“こうだったらいいな”を常に受け取り続ける、実行権限付きのエージェント」

になっている。

ぶっちゃけ、これこそが Nadella の言う“AI ネイティブアプリ”のど真ん中です。

Nadella の「3つの転換」は、ただのマイクロソフト PR ではない

Nadella が 2026 年の「3つの転換」として語ったもの(Opus が要約した内容)は、

- アプリケーションの作り方の転換(AI ネイティブ・エージェント前提)

- 人間とコンピュータのインタラクションの転換(自然言語が第一 UI)

- インフラと経済の転換(AI インフラがプラットフォームの中心)

これだけ聞くと「はいはい、MS のスライドのタイトルね」で流しがちなんですが、今回の GPT-5.2 pro / Opus4.5 の使われ方と並べて見ると、かなりリアリティがあります。

アプリケーションの作り方:

「if-this-then-that」はもう限界

Karpathy の AC 制御って、従来なら

- Home Assistant の YAML 書く

- IFTTT でゴリゴリルール組む

- Node-RED でフローを作る

みたいな世界だったわけですよね。

それが今や、

「9時まではちょっとだけ涼しめ、以降は電気代優先で」

ぐらいを自然言語で伝えれば、あとは LLM が制御ロジックを考える

という世界に向かっている。

正直、既存のホームオートメーション・業務オートメーションの「ルールエンジン」は全部飲み込まれる未来がかなり見えています。

- Zapier 的な if-this-then-that

- 古典的な BPM(ビジネスプロセス管理)

- 社内 RPA のシナリオ

これらはまとめて、

「自然言語で目的を言えば、LLM が

- 必要なツール(API)を理解して

- ルールを生成・改善し続ける」

というエージェントレイヤーに吸収されていく可能性が高いです。

自然言語が第一 UI:

「フォーム設計」の時代が終わりつつある

今回のブックマークまとめでも象徴的なのが、

- 記事執筆者が「こういう軸で要約して」と Opus にお願いする

- Opus が Nadella の話を踏まえたうえで、「この週の本質はここだ」と構造化してくれる

という流れ。

正直、これまで僕らエンジニアは

- どんなフォームを用意するか

- どんなボタンを並べるか

- どんな設定画面を作るか

にかなり頭を使ってきました。

でも、自然言語が本当に第一 UI になってしまうと、

「ボタンとフォームで“操作手段”を設計する」という仕事は減り、

「自然言語から“制約とガードレール”をどう抽出するか」の設計が主戦場になっていく

と感じています。

インフラと経済:

「LLM を使うかどうか」ではなく、「どのレイヤーに組み込むか」

Nadella 的な視点でいうと、すでに

- OS

- Office

- IDE

- CRM

などあらゆる層に Copilot を埋め込んでいるわけですが、

今回のような

- GPT-5.2 pro:高難度推論エンジン

- Opus4.5:編集長&エージェント

というモデルのキャラクター分けを見ると、

「アプリケーションが複数モデルを“前提として持つ”構造」

にかなりシフトしていくのはほぼ確定だと思っています。

- 数学・アルゴリズムは GPT-5.2 pro

- 文書統合・意思決定支援は Claude 4.5 Opus

- 軽量チャットは安価な mid-tier

みたいにモデルをレイヤリング・コンポーネント化した設計が普通になる。

これはクラウドインフラの「マルチリージョン/マルチサービス設計」に近い感覚です。

競合視点:誰が一番ヤバいのか?

まず、従来型「オーケストレーションフレームワーク」は揺さぶられている

正直、LangChain 的な

- 複雑なチェーン構成

- 自前ルーティングロジック

- 思考ステップの外部化

をゴリゴリ書くスタイルは、どこまで必要なのか、再評価が必要になっています。

理由は単純で、

- Claude 4.5 Opus や GPT-5.2 pro が

- 自分でツール選択し

- 自分でプロンプト構造を決め

- 自分で「段階的に考える」ことができるレベルに来ているから

です。

もちろん、

監査・再現性・安全性の観点で、外部にステップを出す価値はまだ大きいですが、

「とりあえず LangChain で複雑に組む」のは完全に時代遅れになりつつある印象です。

これからは、

- LLM に自由度を持たせる部分

- 外側のフレームワークでガチガチに縛る部分

をちゃんと切り分けないと、フレームワークだけが複雑で中身は旧世代という悲しい構造になりがちです。

伝統的ホームオートメーション / RPA ベンダーは本当に危ない

Karpathy の AC は単なるガジェット遊びに見えますが、

あれは Google Home / Alexa / IFTTT / 各種 RPA ツールの未来を先取りしているデモでもあります。

- 「if 温度 > X then 冷房 ON」みたいな定型ルール

- 時間ベースのスケジューリング

- 固定フローの業務プロセス

こういう世界は、人間の自然言語で “意図” を投げて LLM がルールを構成・改善する世界に置き換えられていきます。

特に危ないのは、

- UI が複雑

- 設定が専門職にしかいじれない

- API が閉じている

系のソリューションです。

ぶっちゃけ、「自然言語で話しかけられないオートメーション」は全部レガシーになっていくと思っています。

Google は?という話

今回のブックマークは OpenAI / Anthropic / Microsoft 寄りの話が中心でしたが、

逆にいうと「Google の影が薄い」のが気になります。

- FrontierMath の具体的数字での殴り合い

- Agentic な use case の象徴的事例

- 大手経営者の「世界観」ストーリーテリング

このあたりで、ここ最近 Google が話題の中心に来ていない印象があるのは否めません。

もちろん、Gemini 系や社内向けにはいろいろ進んでいるのでしょうが、

「Karpathy の Jarvis みたいな、開発者がワクワクする象徴的ユースケース」をどこまで出せるかが、2026 年前半の勝負どころかなと感じています。

ただ、懸念点もあります…(ここ大事)

ここまでいい話ばかりしてきましたが、

プロダクションで使うエンジニアとしては、冷水を浴びせる話もしておきたいです。

コスト:常駐エージェントは「気づいたら請求爆死」リスク

Jarvis 的な home automation・業務エージェントって、聞こえは最高なんですが、

「常に動いている」「細かいことも全部 LLM に相談する」

という構造になるので、トークン消費がエグくなりがちです。

- 温度変化をこまめに見て調整

- スケジュールに応じてちょこちょこ判断

- 例外処理でさらにプロンプトが増える

これを全部 GPT-5.2 pro や Claude 4.5 Opus に投げていたら、

月末に請求書を見て固まる未来が普通にありえます😇

実務的には、

- 「重い判断だけ pro / Opus に投げる」

- 「軽い処理はローカルルール or 安価モデルに落とし込む」

- 「LLM で学習したポリシーを一旦“静的ルール”にコンパイルして、しばらくはそれで回す」

みたいな階層化設計が必須だと思います。

安全性・デバッグ性:「うまくいっているときほど危ない」

物理世界をいじるエージェントは、とにかく安全性とデバッグ性が鬼門です。

- 気まぐれに推論を変える

- コンテキストのちょっとした違いで挙動が変わる

- 「なぜその判断をしたか」がログから追いにくい

こうなると、事故が起きたときに原因をトレースできないという、

ソフトウェアエンジニアとしては一番イヤな状況に陥ります。

個人的には、

- LLM に直接デバイスを操作させない

- LLM → 「提案」と「ポリシーコード」を吐く

- 人間 or 別プロセスがそれを検証してから適用する

- すべてのアクションに

- 「どのプロンプトから生まれたか」

- 「どのツール呼び出しが関わったか」

を紐づけるトレース ID をつける

くらいは、Jarvis 的なことをやるなら最低限欲しいと思っています。

ベンダーロックイン:

「Opus4.5 前提アーキテクチャ」は後から地獄を見る

GPT-5.2 pro と Claude 4.5 Opus は、正直どちらもめちゃくちゃ優秀です。

でも、どちらか一社にどっぷり依存する設計はやっぱり怖い。

- 価格改定

- 利用規約変更

- モデル更新による挙動変化

- 地政学的リスク

どれがトリガーになってもおかしくありません。

ぶっちゃけ、API の形だけ揃えた「なんちゃってマルチベンダー対応」では足りないと感じています。

- 数学タスクは OpenAI 系

- 文脈統合は Anthropic 系

- それぞれに対して、独自の評価・テストスイートを持つ

みたいな、「本気のマルチモデル運用」を前提に設計する時期に入っています。

メタ要約への過信:「ちゃんと元ソースを読まない病」が加速する

Opus が編集長として優秀になればなるほど、

人間側は「要約だけで分かった気になる」病にかかりがちです。

特に、

- コンプライアンス

- 法務

- 医療・ヘルスケア

- セキュリティ

みたいな領域で、LLM 要約だけで判断するのはかなり危険です。

個人的なルールとしては、

- クリティカル領域の判断は「原文+要約」をセットで読む

- 要約には必ず原文へのリンクと証拠(引用)を添付させる

- LLM に「反対意見・マイナー意見」を意図的にサーチさせる

くらいはやらないと、世界の情報がどんどん“丸められて均一化される”危険があると感じています🤔

じゃあ、プロダクションでどうするか?ぶっちゃけまだ様子見?

最後に、エンジニアとして「今週のアップデートを受けて何をするか?」を自分なりにまとめると、こんな感じです。

✅ 今やる価値が高いこと

- GPT-5.2 pro を、数理/アルゴリズム系タスクで試験導入

- 既存の 5.x や他社モデルと比較評価

-

特に「今は人間が頑張ってるけどしんどい」数式系処理に当ててみる

-

Claude 4.5 Opus を「編集長」として試す

- チームの週次レポート

- 社内ドキュメント要約

-

顧客ログの週次サマリ

などを Opus にやらせて、「どこまで任せられるか」「どこから危ないか」を体感する -

Karpathy 的「vibe coding」を小スケールで真似してみる

- いきなりエアコンじゃなくて、

例:Slack 通知・レポート生成・テスト実行ルールなど -

「自然言語で目的を伝え → LLM がポリシーを生成 → それを適用」

というパターンを小さく回してみる -

プロダクト設計で「LLM 常駐前提」のアーキテクチャをスケッチしてみる

- 今のシステムを、

「どこにエージェントを挟めるか」「どこは絶対挟みたくないか」

という観点で棚卸しする

⚠️ まだ様子見したいこと

- 24/7 で物理デバイスを直接制御するエージェントの本番運用

-

監査・ロギング・フェイルセーフをガチガチに作れるチーム以外は、まだ控えめが良さそうです

-

全社情報フローを LLM メタ要約に全面委任

-

情報の「丸めすぎ」問題とロックイン問題があるので、

今は「副編集長」止まりにしておくのが現実的かなと感じています -

単一ベンダー前提のアーキテクチャ

- まだ業界全体の勢力図が固まりきっていないので、

2026 年の上半期は意識的にマルチモデル前提の設計をしておいた方が安全だと思います。

まとめ:2026 年は「LLM が OS に常駐する年」になる

2025 年までは、

- Copilot がちょっと賢くなる

- チャットボットの精度が上がる

- コード補完が改善される

みたいな、「既存のツールが便利になるフェーズ」でした。

でも、今回の

- GPT-5.2 pro の FrontierMath Tier 4 29.2%

- Claude 4.5 Opus の編集長+Jarvis 的ユースケース

- Nadella の「3つの転換」ストーリー

を並べて見ると、2026 年は明らかに

「LLM がアプリの“外側”ではなく、“内側”に常駐することを前提に設計する年」

に入ったな、という感覚があります。

正直、全部を一気に追いかけるのは無理です。

でも、

- どこで GPT-5.2 pro のパワーを使うか

- どこまで Claude 4.5 Opus を編集長/エージェントとして信頼するか

- どこにエージェントを常駐させて、どこはあえて人間主導に残すか

を意識して設計できるチームと、

「何となく新モデルに乗り換えるだけ」のチームとでは、

2026 年末にはかなり大きな差がついていると思います。

あなたのプロダクトでは、

まずどこに「小さな Jarvis」を置きますか?

コメント