「マルチツールAIをプロダクションに入れたら、ツール配線だけで一日終わるんだが?」

そんな経験、ありませんか?🛠️

- LangChainだのLangGraphだのを駆使して

- プランナーLLMとエグゼキュータLLMを分けて

- さらに外部APIや自前のマイクロサービスをツールとして生やして…

気がついたら「プロダクト」ではなく「自作エージェント基盤」を作っていて、本来やりたい機能開発が全然進まない。

正直、ここ1年くらいのAIプロダクト開発って、そんな「配線地獄」にハマっているチームが多い印象です。

そんな中で出てきたのが、MiniMax M2.1、Solar Open 100B、Qwen-Image LoRAシリーズ、SD.cpp-WebUI、ComfyUI-HY-Motion1、JavisGPT、YOLO11…

今回は「新しいのいっぱい出ましたね」という話ではなく、

これってクラウド以前の「Docker + なんちゃってオーケストレーション」時代とめちゃくちゃ似てない?

という視点でまとめてみます。

- 一言でいうと:「AI界の2015年Kubernetes前夜」が始まった

- MiniMax M2.1:LLMというより「ツール・オーケストレータ as a Service」

- Solar Open 100B:Llama 3を横目に「もっとデカくてもっとオープン」を突きつける存在

- Qwen-Image LoRA:ベンダー公式LoRA戦略は「Stable Diffusion時代の再演」になりうる

- SD.cpp-WebUI & YOLO11 & Jetson Nano:古いハードが「AI的に復活」する流れ

- JavisGPTと「エージェントOS」幻想

- ComfyUI-HY-Motion1:動画は「インフラの現実」を直撃してくる

- 結局、何が起きているのか:単一LLM時代から「エコシステム設計」の時代へ

- じゃあ、プロダクションでどれを使うのか?個人的な結論

- まとめ:今は「Kubernetes前夜」、基盤を選びすぎない方がいい

一言でいうと:「AI界の2015年Kubernetes前夜」が始まった

ざっくり整理すると、今回のラウンドアップはこういう構図になっています👇

- MiniMax M2.1 / Solar Open 100B / Qwen-Image

→ 「AIランタイム」= Dockerイメージに近い基盤モデルたち - Qwen-Image LoRA / YOLO11 / Pixel-art LoRA

→ 特定用途向けのコンテナやライブラリ - JavisGPT / ComfyUI-HY-Motion1 / SD.cpp-WebUI

→ オーケストレーション/UIレイヤー(なんちゃってKubernetes & Compose枠) - Jetson Nano / A.X K1 / Walker S2 / GR-Dexter / 未来のAppleグラス

→ エッジノードやロボット=ランタイムが動く「クラスタの端っこ」

ぶっちゃけ、今起きているのは「大規模LLM API時代」から

「マルチモデル+マルチツールを前提としたエコシステム時代」へのシフトです。

MiniMax M2.1:LLMというより「ツール・オーケストレータ as a Service」

MiniMax M2.1は、ただの「GPT-4o相当っぽいマルチモーダルモデル」ではなく、

マルチツール・マルチエージェントを前提にしたLLM

として設計されているのがポイントです。

- 画像+テキスト+ツール呼び出しを一体として扱える

- 中国語・日本語もかなり強い(≒アジア圏向けの現実的な選択肢)

- 「プランナー+ツール実行」をモデル側で回す前提のAPI

これがなぜ重要か

今まで我々は、

- 汎用LLM(OpenAI / Claude / Llama…)を呼び出して

- LangChainや自作フレームワークで「ツールの配線」「プランニング」「リトライ戦略」などを頑張る

という構図でした。

MiniMax M2.1の発想は、ここをAPI側に寄せることです。

- 「このツール群を使ってこのゴールを達成して」と投げる

- 中のプランナーが、必要に応じてツールを使い分ける

正直、うまく動くならめちゃくちゃ楽です。

特に中国語・日本語混在の業務でツールを叩きたい場合、

英語LLM+自前オーケストレーションよりも自然な体験になる可能性が高い。

でも、正直一番怖いのは「デバッグ不能のブラックボックス化」

懸念点もかなりあります 🤔

- ツールの呼び出しロジックをMiniMax側に渡す=

オーケストレーションまで含めてベンダーロックイン - プランニングの失敗をどうデバッグするか?

- どのエージェントが何を判断してミスったのか

- どのツール呼び出しが原因か

- 将来、別ベンダーのモデルに乗り換えるときに、

「ツールの契約」だけでなく「オーケストレーションの思想」ごと書き直しになるリスク

ぶっちゃけ、

「ツール配線の地獄」から逃げると、「ベンダー専用オーケストレーション地獄」に引っ越すだけ

という未来も全然ありえます。

MiniMax M2.1は、そのトレードオフを理解したうえで使うべきモデルです。

Solar Open 100B:Llama 3を横目に「もっとデカくてもっとオープン」を突きつける存在

Solar Open 100Bは、100BクラスのオープンウェイトLLM。

Llama 3 70B や Qwen2-72B が「事実上の標準」になりつつある中で、

「規模でも、ライセンスの開放性でも、もう一段上行きます」

と宣戦布告しているポジションです。

Llama 3 70B vs Solar Open 100B:どっちが現場目線で嬉しい?

Llama 3 70B の強み

- すでにエコシステムが成熟

- vLLM / ExLlama / TensorRT-LLM などサポート豊富

- 量子化・Distillation・推論最適化のノウハウ多数

- 「とりあえずLlamaでしょ」が通用するほどのデファクト感

Solar Open 100B の武器

- 単純にパラメータ数が大きい(100B)

→ 長文推論・専門領域での表現力に期待 - 「商用でガチで使ってOK」というオープン性アピール

- Llama系の「競合制限」的なものに疲れた企業には刺さる

- 国・産業によっては、米国BigTech依存を下げたいニーズもある

正直なところ:「GPUクラスタを持ってない会社には関係ない」

100Bクラスを自前で回す現実をちゃんと見るべきです。

- 実運用だと

- A100/H100を複数枚、もしくはそれに相当するクラスタ

- シャーディング、テンソル並列、チェックポイント管理

- そこに

- ログ収集

- モニタリング

- A/Bテスト基盤

- SLO(レイテンシ・エラー率)の管理

ここまで含めると、

「APIでGPT-4クラス叩いた方が安いし早い」という会社が大半だと思います。

Solar Open 100B が本気で刺さるのは、

- すでにGPUクラスタを持っている大企業/研究機関

- 規制や国の事情で「海外SaaS APIをメインにはできない」組織

- Llama 3 70B では物足りず、「もっとデカい自己ホストモデルを武器にしたい」企業

この辺りです。

プロダクト初期フェーズのスタートアップが

「かっこいいからとりあえずSolar 100Bをホストする」は、

ぶっちゃけ技術的自己満足に終わる可能性が高いです。

Qwen-Image LoRA:ベンダー公式LoRA戦略は「Stable Diffusion時代の再演」になりうる

Qwen-Image-2512 の上に、

- 高速・汎用向けの Turbo-LoRA

- レトロ・ドット絵特化の Pixel-Art-LoRA

が「公式LoRA」として出てきたのは、かなり象徴的です。

なにが新しいのか?

正直、LoRA自体は目新しい技術ではないです。

でも、ここで効いてくるのは「戦略としてのLoRA」の方。

- ベースモデルはひとつ(Qwen-Image-2512)

- そこに公式LoRAを複数ぶら下げて

- 高速用途

- ピクセルアート

- (今後出るであろう)他ジャンル

という**「ベース+公式アダプタ」の形にしている。

これは、Stable Diffusionの

- SD1.x / SDXL がベース

- 各種スタイルモデルやLoRAがコミュニティから乱立

というカオスを、「公式のサブモデル群」として整理し直そうとしている動きに見えます。

ぶっちゃけ、これから始まるのは「LoRA地獄」と「ルーティング地獄」

開発者視点での懸念はかなり明確です。

- どのLoRAをいつ適用すべきか?

- ユーザーが「ドット絵で」と言ったらPixel-Art-LoRA

- そうでなければTurboかベース

- 将来、LoRAが10種類、20種類と増えたとき

- プロンプトから適切なLoRAを自動選択するルーティングロジックが必要

- それをまたLLMに任せると、制御不能なループが生まれる

結果として、

「モデルは細分化すればするほど、上位レイヤーのオーケストレーションが複雑になる」

という構図がさらに加速します。

ただし、これは悪いことだけではなくて、

- 小さなチームや個人開発者は、公式LoRAに乗っかるだけでかなりの品質を得られる

- 独自LoRAを作っていたニッチなスタジオは

「公式LoRAに勝てる独自価値は何か?」を問われる

という健全な淘汰も起きるはずです。

SD.cpp-WebUI & YOLO11 & Jetson Nano:古いハードが「AI的に復活」する流れ

SD.cpp-WebUI、YOLO11、Jetson Nano の組み合わせは、

正直いちばん「開発者の生活を具体的に変える」部分かもしれません。

- sd.cpp ベースの軽量WebUIで Stable Diffusion 系がCPU/低VRAMでも動く

- YOLO11 でエッジでもそこそこ賢い物体検出

- Jetson Nano みたいな「数年前のボード」でそれなりに回る

これは単なる「貧者のAI」ではない

一見すると、

「お金ない人向けのローカルAIでしょ?」

という話に見えますが、もっと重要なポイントがあります。

- ロボティクスやIoTでのプロトタイピング速度が劇的に上がる

- 「とりあえず手元の古いJetsonで試す」が現実的になってきた

- クラウド接続前提ではない「オフラインAI体験」を真面目に設計できる

たとえば、

- Jetson Nano 上で YOLO11 で物体検出

- 必要なときだけクラウドのLLMに問い合わせ

- 画像生成はSD.cpp-WebUIでローカルに(遅いのは割り切る)

みたいなハイブリッド構成が個人レベルでも普通に組める時代になっています。

とはいえ、ユーザーの期待値とのギャップは大きい

ただ、ここにも落とし穴があります。

- 一般ユーザーの「AI体験の基準」はぶっちゃけGPT-4レベル

- Edgeのローカル推論は

- 遅い

- 品質もそこそこ

- モデルサイズの制約もきつい

このギャップをどう説明するか、どうUI/UXで吸収するかは、

今後のエッジAIプロダクトの大きな課題です。

JavisGPTと「エージェントOS」幻想

JavisGPT は、いわゆる「Jarvis的なマルチエージェント・ツールオーケストレーションプロダクト」です。

- プランナー

- リサーチャー

- エグゼキュータ

みたいな役割を複数エージェントに振って、いろんなAPIを叩きながらタスクをこなすやつですね。

なぜ今これが増えているのか

MiniMax M2.1 もそうですが、

「1回のLLMコールでは終わらない複雑なタスク」を現実的に処理するには、

- 分割

- 計画

- ツール呼び出し

- 検証

- リトライ

といったプロセスが必要で、それをUI付きで提供しようとすると

自然に「エージェントOS」っぽい顔をし始めます。

でも、ぶっちゃけ現状の「自律エージェント」はかなり過大評価されている

正直なところ、現行のマルチエージェントシステムには、こういう懸念があります。

- エラーが複利で増える

- プランナーのミス × ツール選択のミス × LLM hallucination

- どこで何が起きたのかトレースしづらい

- ユーザーの期待値が「ほぼ人間のアシスタント」なのに対して

- 実態は「ちょっと頭のいいスクリプト」の域を出ないことも多い

つまり、

「全部自動でいい感じにやってくれるJarvis」が欲しい

vs

「実際には、たまに役に立つがしょっちゅう変なこともするボット」

というギャップが非常に大きい。

JavisGPTのようなプロダクトは、

- エージェントの権限をどこまで許すか

- どこで人間の確認を挟むか

- 失敗時のリカバリをどう設計するか

をちゃんと設計しないと、

「デモはすごいけど実運用では怖くて使えない」代表例になりかねません。

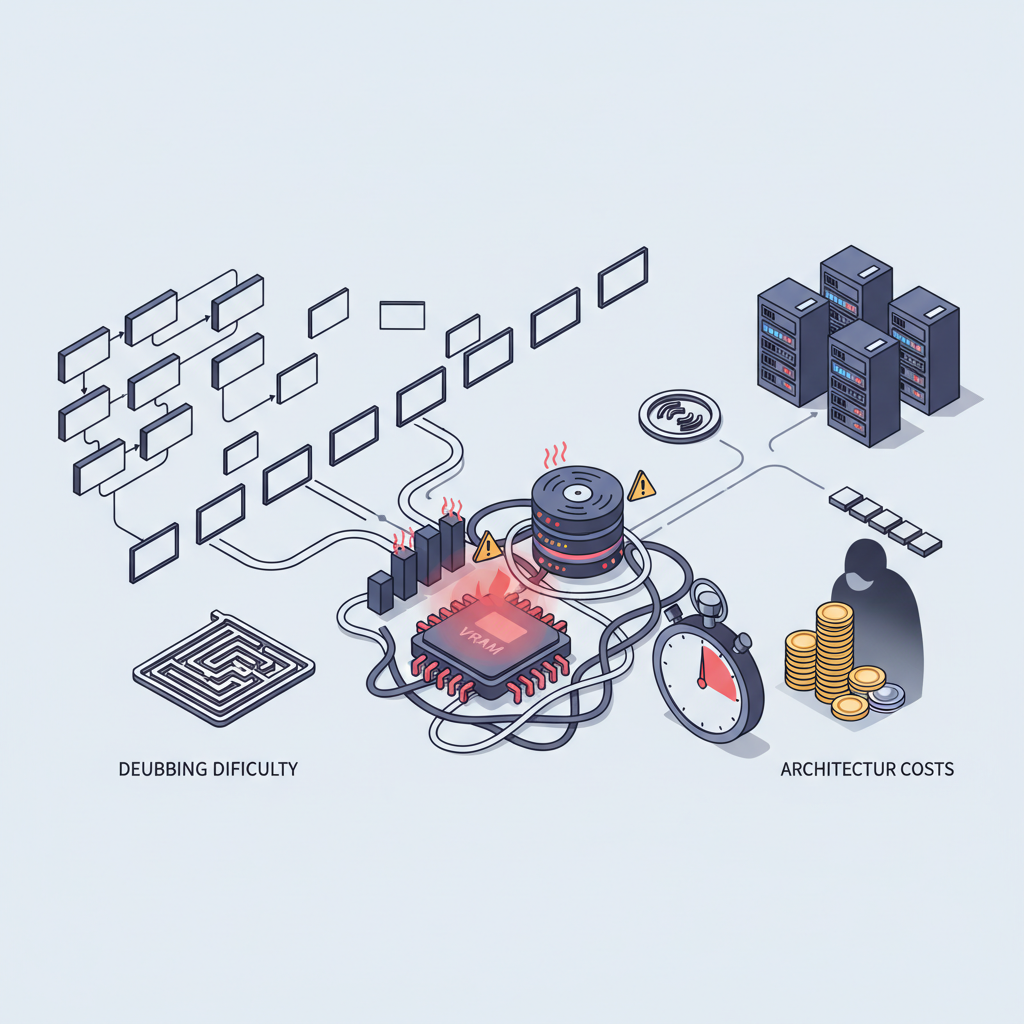

ComfyUI-HY-Motion1:動画は「インフラの現実」を直撃してくる

ComfyUI-HY-Motion1 は、

画像世代の定番ツールになりつつある ComfyUI に「動画生成」を持ち込む拡張です。

- 既存のノードグラフにモーション/時系列の概念を足す

- 画像→短い動画、のようなパイプラインが組みやすくなる

個人クリエイターには夢のよう、だがインフラには悪夢

動画生成は桁違いに重いです。

- VRAM消費

- ディスクI/O

- 推論時間

どれをとっても静止画とは別世界で、

そこにさらに「複雑なノードグラフ」が乗ってくると、

- デバッグがしんどい

- 再現性が取りづらい

- CI/CDのテストも組みにくい

という、MLOps的にはかなりハードな世界になります。

プロダクトとして組み込む場合は、

- 動画生成を「オンライン処理」にするのか「バッチ前提」にするのか

- ユーザーにどこまで待たせる設計にするのか

- 料金体系(課金)とどう紐づけるのか

まで含めて考えないと、

「GPU請求書だけが増える地獄」にハマります。

結局、何が起きているのか:単一LLM時代から「エコシステム設計」の時代へ

ここまで挙げてきたものを全部並べてみると、共通するメッセージがあります。

「でかいLLMさえあればOK」という時代は、もう完全に終わった

これから必要になるのは、

- どのレイヤーをどのベンダーに任せるかの設計

- 基盤モデル(Solar / Llama / Qwen / MiniMax…)

- オーケストレーション(自前 / MiniMax / JavisGPT…)

- エッジ推論(Jetson / PC / モバイル)

- モデルの細分化と統合のバランス

- Qwen-Image LoRA的な「公式サブモデル」をどこまで採用するか

- 自前LoRA・自前fine-tuneをどこまで増やすか

- 運用コストの現実直視

- Solar Open 100Bクラスを本当に自前で持つのか

- Edge vs クラウドのトレードオフ

- マルチエージェントの失敗を誰が責任持って面倒を見るのか

じゃあ、プロダクションでどれを使うのか?個人的な結論

最後に、「今これをプロダクションで採用するか?」という観点でざっくり整理しておきます。

MiniMax M2.1

- 現状の結論:

- 中国・日本向けサービスで

「マルチツール前提のエージェントUXを早く出したい」なら検討する価値あり - ただし、

- オーケストレーションごとベンダーロックインになる覚悟

- デバッグ難易度の上昇

を理解してから。

- 自分なら:

- まずはPoC用途で入れて「どこまで任せられるか」を見極めてから、本番採用を判断。

Solar Open 100B

- 現状の結論:

- すでにGPUクラスタを運用している企業 or 主権性が重要な組織以外はまだ様子見

- 自分なら:

- Llama 3 70B インフラがまだない状態で、いきなりSolar 100Bをホストし始めるのはやらない。

- まずはAPIや小型モデルでプロダクトマーケットフィットを探し、それでもなお「自己ホストが絶対必要」なフェーズに来てから考える。

Qwen-Image LoRAシリーズ

- 現状の結論:

- 画像生成・理解をプロダクトに組み込みたいWebサービスにはかなり実用的

- とくに「高速版」「特化スタイル」が公式で出る流れは歓迎。

- 自分なら:

- まずはTurbo-LoRAを標準として採用し、Pixel-Art-LoRAは「ドット絵モード」など明示的なUXに紐づけて限定的に使う。

- LoRA乱立によるルーティング地獄は、初期段階ではあえて避ける。

SD.cpp-WebUI / YOLO11 / Jetson Nano

- 現状の結論:

- ロボティクス・IoT・学習用途には積極的に推したい組み合わせ。

- ただし「クラウドLLM並みの体験」は絶対に期待しないこと。

- 自分なら:

- 個人プロジェクト・PoC・デモ機にはどんどん使う。

- 大規模ユーザー向けプロダクトの中核には据えず、「エッジ補完的な役割」にとどめる。

JavisGPT / ComfyUI-HY-Motion1 系

- 現状の結論:

- デモ・R&D・クリエイティブ用途には最高。

- でも「フル自律エージェント」や「動画自動生成」を本番の中心機能に据えるのはまだ危険。

- 自分なら:

- 社内ツールや限定ベータ版で試し、

- 人間のレビュー/承認を前提としたワークフローとして組み込む。

- いきなり「人間ごと置き換える」設計にはしない。

まとめ:今は「Kubernetes前夜」、基盤を選びすぎない方がいい

今のAIエコシステムは、

2015〜2017年ごろの「Dockerはあるけど、Kubernetesはまだカオス」な時期に非常によく似ています。

- ベストプラクティスはまだ固まっていない

- 各社が「自分こそが標準になりたい」と独自路線を走っている

- インフラの難しさをユーザーから隠しきれていない

こういうフェーズで一番まずいのは、

「特定のスタックに全賭けしてしまい、後から抜け出せなくなること」

だと思っています。

- MiniMax M2.1 のようなオーケストレーション込みのLLM

- Solar Open 100B のような巨大自己ホストモデル

- Qwen-Image LoRAのようなベンダー公式サブモデル

- JavisGPTのようなエージェントOS

どれも面白く、ポテンシャルは高い。

ただし、それぞれが将来のロックインポイントになりうることも意識しておくべきです。

正直、今の段階でのおすすめスタンスはこんな感じです👇

- 新しいものはPoCと限定用途でどんどん試す

- ただし、基幹システムや長期運用前提の部分には慎重に入れる

- モデル単体ではなく、「エコシステムとしてどう付き合うか」を最初から設計する

つまり、

プロダクションでフルコミットするには、正直まだ様子見。

でも、試さずに乗り遅れるのはもっと危険。

このバランス感覚が、ここ1〜2年のAIプロダクト開発では一番重要になると感じています。

コメント