「血液検査の結果をPDFで送るから、要点だけ教えて」

「Appleヘルスケアに全部入ってるから、そこ見て判断して」

…こう言いたくなったこと、ありませんか?

でも現実には、医師側も患者側も、散らばった健康データと格闘しながら、毎回ゼロから説明し直しているのが今の医療ITです。

そんな状況に、OpenAIが「ChatGPT Health」という爆弾を投げ込みました。

正直、これは“単なるヘルスケア向けチャットボット”ではありません。

一言でいうと:「LLM版 AWS HealthLake」がとうとう来た

ざっくり言うと、ChatGPT Health は

ChatGPT + 医療記録/EHR/ウェルネスアプリ連携 + コンプライアンス設計済み

という「ヘルスケア特化マネージド LLM サービス」です。

歴史的に言うと、AWS が「EC2/S3 だけで医療システムもがんばって動かしてた時代」から、

FHIR/DICOM 対応の AWS HealthLake / HealthImaging を出してきたタイミングにすごく似ています。

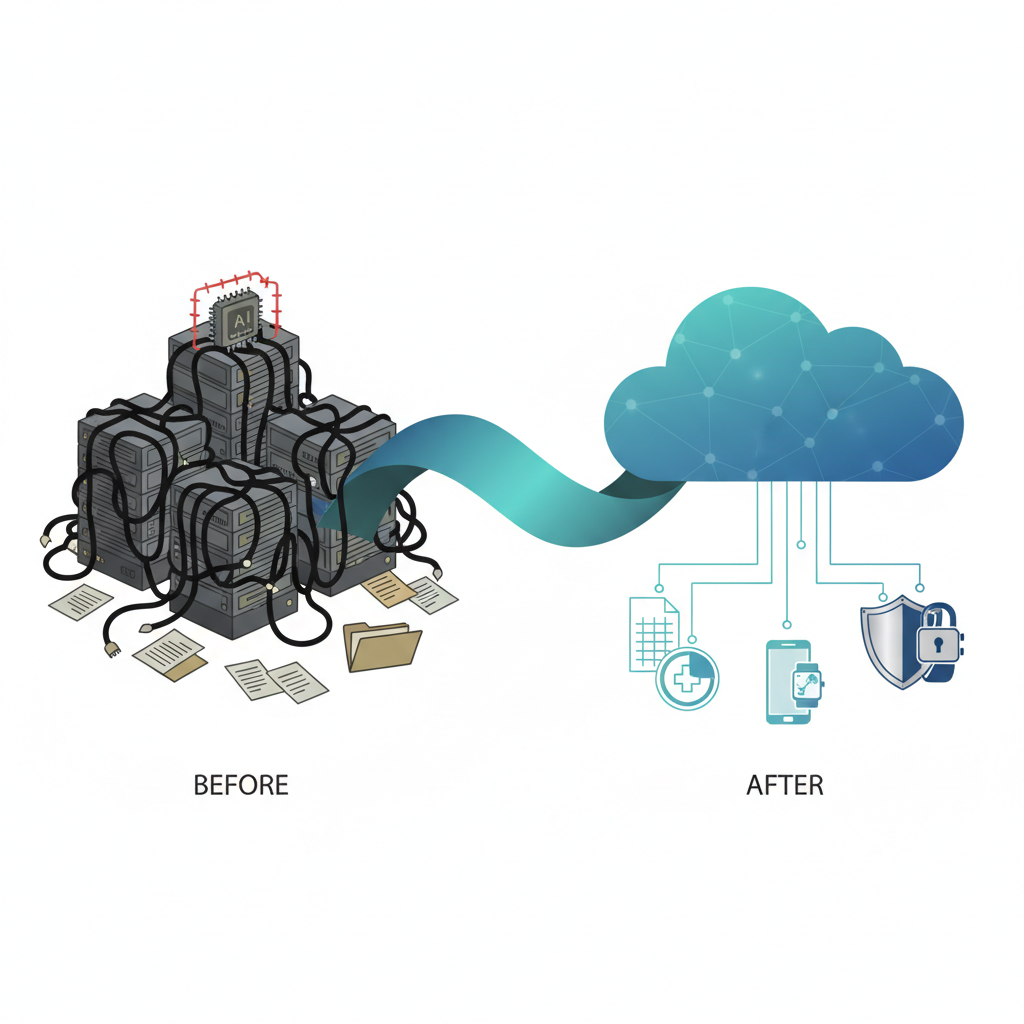

- これまで:

- 汎用GPTに自前RAG、ガードレール、規制対応を被せて「なんちゃって医療AI」を作っていた

- これから:

- 医療記録連携とセーフティが最初から前提の ChatGPT Health を土台にする

というゲームチェンジが起きる可能性が高いです。

何が本当にヤバい(=価値がある)ポイントか

正直、「健康アドバイスできます!」だけなら、ここまで騒ぐ必要はありません。

今回ガチでインパクトがあるのは、次の3点です。

医療記録(EHR/EMR)と “公式に” つながる前提で作っている

ZDNet/ITmedia の記事から読み取れる範囲でも、

- 電子カルテ(EHR/EMR)

- Apple ヘルスケア

- MyFitnessPal / Function / WeightWatchers

- AllTrails / Instacart / Peloton

などのデータと連携して、

- 検査結果の要約・説明

- 受診歴をふまえた質問整理

- 食事メニュー・運動プランのパーソナライズ

までやる設計になっています。

ここが「ただのプロンプトテンプレ付き ChatGPT」とは全く違うところで、

「データ連携」そのものをプロダクトの一級機能として設計している

のがポイントです。

今まで医療系SaaSを作ってきた人ならわかると思いますが、

EHRとの連携まわりは、技術よりも政治とコンプラとの戦いなんですよね…。

そこに「OpenAI公式のヘルスケア垂直プロダクトです」と看板を立ててきた意味はかなり大きいです。

「診断」ではなく「説明・理解支援」にポジショニングしている

ChatGPT Health 自体も、

「診断・治療の代替ではない」とかなり強調しています。

- 検査結果の意味を、患者向けに平易に説明

- 受診前に聞きたいことの整理

- 生活習慣やセルフケアのアドバイス

- 保険プラン比較、次のステップの理解支援

など、「医師の代わり」ではなく「医師の話をわかるようにする側」に寄せている。

これは技術的な限界というより、責任分界をかなり意識した設計だと思います。

ぶっちゃけ、ここを踏み違えると一気に規制・訴訟コースなので、

この「説明特化」のポジション取りは、かなり現実的な落としどころです。

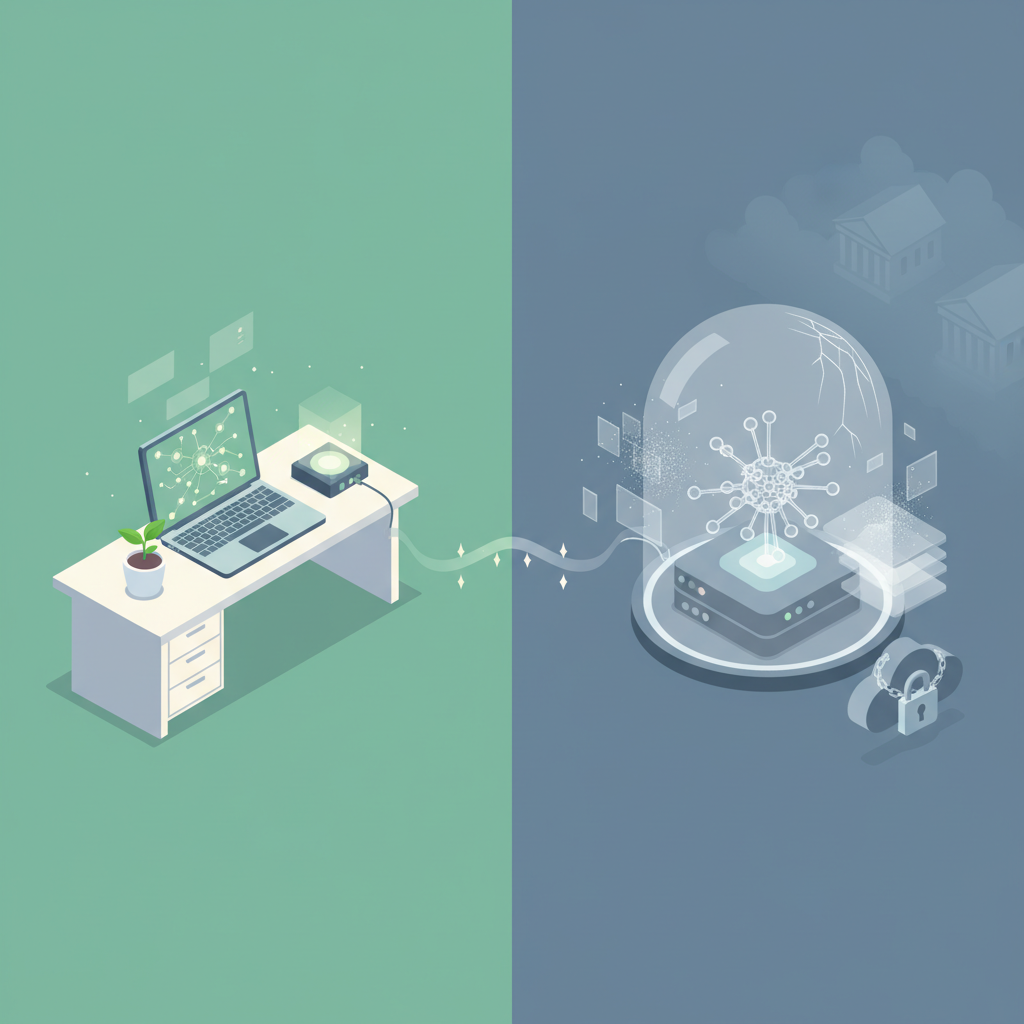

コンプライアンス前提の LLM ワークフロー

- 健康データは通常チャットと分離した専用スペース

- 専用の暗号化・隔離処理

- モデル学習への不利用

- アクセス許可はアプリごとに明示的に付与・解除可能

といった「Enterprise / regulated industry 向けの作り」が前提になっています。

ここまでやらないと、医療機関は本番導入してくれません。

逆にいうと、

「PoC止まりの LLM 医療プロジェクト」から一歩踏み出すための最低条件

をようやく満たしてきた、とも言えます。

これ、誰が一番ヤバいのか?(競合の話)

開発者・事業者目線で一番気になるのはここだと思います。

一番プレッシャーを受けるのは「医療LLMスタートアップ」

- カルテ自動要約

- 診療録ドラフト生成

- 患者向け説明テンプレ生成

- 生活習慣アドバイス

…みたいなものを「うちのモデルは医療特化で安全です!」と売っていたスタートアップは、

正直かなり苦しくなります。

なぜかというと、

OpenAI が「モデル+ガードレール+データ連携+コンプラ」を

まとめて“プラットフォーム”として用意してしまったから

です。

モデルの fine-tuning やセーフティそのものを差別化ポイントにしていた会社は、

価値の源泉がごっそり削られます。

これからは、ドメイン特化ワークフローと現場導入力で勝負するしかない。

EHR/EMR ベンダーも「AI全部自前」はかなり厳しい

電子カルテベンダーも、

- AI要約機能

- 音声→カルテ生成

- 患者向け説明文自動生成

あたりを、これまで自前 or 小さなベンダーと組んで実装してきましたが、

ここにも ChatGPT Health が正面から突っ込んできます。

現実的な未来としては、

- AIの中核は ChatGPT Health / 他社LLM に任せる

- 自社は UI/ワークフロー・業界ノウハウに特化

という「再定義」を迫られるはずです。

Microsoft / Nuance とは「局地戦の競合+共存」

医療AIで既に強いのは Nuance Dragon Ambient eXperience (DAX) ですが、

立ち位置は少し違います。

- Nuance DAX

- 診察室の会話をリアルタイムに聞き取り、

→ 既存 EHR(Epic/Cerner 等)にがっつり組み込んでカルテを生成 -

“診察ワークフロー” に深く入り込む音声特化型

-

ChatGPT Health

- 会話体験と LLM の柔軟性 + 医療記録・ウェルネスアプリ連携

- “医療記録+患者コミュニケーション全般” を広くカバー

正直、今のところは

- 病院の巨大導入案件:Nuance / Microsoft がまだ優位

- その周辺の SaaS / B2C ヘルスケアアプリ:ChatGPT Health プラットフォームに乗るプレイヤーが増える

という住み分けになる気がします。

なぜ今出てきたのか:コミュニティの空気を踏まえると見えてくること

OpenAI 自身が言っているように、

「すでに毎週 2.3 億人以上が ChatGPT に健康相談している」という現実があります。

コミュニティの声を見ても、

- 「ちょっとした体調の相談や生活習慣の見直しにもう使っている」

- 「病院行くほどではない“ゆるい健康相談窓口”として便利」

というライトユースは、すでに当たり前になっている一方で、

- 電撃パブロフ装置(健康的な生活を送らないと API 経由で腕に電撃)みたいな、

ブラックジョーク的ユースケースも出てきている - 「AI とデバイスに体を管理されすぎるのは怖い」という違和感も強い

という“ブラックミラー感”も漂っています。

OpenAI としては、

どうせみんな医療・健康相談に使ってるなら、

せめて専用のレールとガードレールを用意して、事故を減らしたい

という動機もかなり大きいはずです。

放っておくと「電撃パブロフ × AIヘルスコーチ」みたいな危ない方向に勝手に進むので…。

ただ、懸念点もあります…🤔

ここまで聞くと夢のようですが、正直、実務者目線での「Gotcha」もかなり多いです。

コスト:PoC は安くても「全患者対応」は一気に重くなる

医療向けは「高付加価値+高リスク」ゆえに、

ChatGPT Health が通常 ChatGPT より高単価になる可能性はかなり高いです。

- PoC:

- 一部外来で限定実験 → 「おお、すごいじゃん」で終わる

- 本番:

- 全外来・全患者・24/7 対応に広げる

→ 推論コスト+連携維持コストが一気に跳ね上がる

これ、クラウド黎明期に「PoC は安かったけど、本番運用で AWS 請求額がエグい」ってなったときと同じ構図です。

ぶっちゃけ、「医療LLMを自前で作る vs ChatGPT Health に乗る」の比較は、

性能・安全性だけでなく、長期コストと価格交渉力もちゃんと見ないと危険です。

ベンダーロックイン:ワークフローごと OpenAI に握られるリスク

健康データ連携とワークフロー設計まで ChatGPT Health 前提で作り込むと、

- 出力フォーマット

- プロンプト設計

- エラーハンドリング

- UI の前提

などが、ことごとく OpenAI 仕様に染まっていきます。

将来、

- 他社モデルに載せ替えたい

- オープンモデル+オンプレでコスト最適化したい

と思ったときに、全面的なアーキテクチャの組み直しが必要になる可能性が高いです。

「LLM を交換可能なコンポーネントとして扱う設計」をどこまで守れるかが、

アーキテクトの腕の見せどころになりそうです。

「責任も OpenAI が取ってくれる」という誤解

現場で一番危ないのはここだと思っています。

- 「OpenAI が医療用と言っているんだから、かなり安全なんでしょ?」

- 「HIPAA 準拠っぽいし、うちの責任もだいぶ減るよね?」

という空気が、経営層や現場に広がるのが一番まずい。

実際には、

- 診断・治療の最終判断責任は医師・医療機関にある

- LLM の出力を「決定支援としてどう使うか」を設計した側にも責任が発生する

- ワークフロー設計次第で、責任分界が大きく変わる

という現実は何も変わりません。

ここを勘違いすると、

「AI がそう言ったから…」という

最悪パターンのインシデントレポート

を量産する未来が見えてしまいます。

モデルの限界と“もっともらしい間違い”

ChatGPT Health といえども、中身はあくまで確率的生成モデルです。

- 医療特化データで fine-tune されていようと

- ガードレールが厚く乗っていようと

「それっぽいけど間違っている回答」は必ず出ます。

現実的な落としどころは、

- 診断・処方の自動化には絶対使わない

- 文章要約・ドラフト生成・説明のたたき台として使う

- 人間の専門家レビューを前提にしたワークフローを組む

という、「AI は一次入力、最終決定は人間」という線引きを徹底することです。

開発者視点:アーキテクチャはこう変わる

エンジニアとして一番インパクトがあるのは、

「何を自前でやるか」の境界線が動くことだと思っています。

これまで医療系アプリでやっていたこと:

- 自前 RAG 構成

- 医療ガイドラインに沿ったセーフティプロンプトの設計

- 医療用知識ベースの作り込み・更新運用

- コンプラ周りの説明と体制づくり

これから(理想的な世界):

- ChatGPT Health をフロント/バックエンドとして利用

- 自社側は:

- ドメイン固有 UI

- ローカルルール・ワークフロー

- 監査・ログ・説明責任フレームワーク

に集中できる。

一方で、攻めたプロンプト設計・ギミックはだいぶやりにくくなるはずです。

OpenAI 側にかなり強いシステムプロンプトと制約が入るのはほぼ確実なので、

「ちょっと規制ギリギリだけど、こういうこともできちゃうんだよね」

みたいなハック的アプローチは封じられる可能性が高い。

ここを窮屈と感じるか、「危険な実装を減らしてくれて助かる」と感じるかは、人によって分かれそうです。

じゃあ、プロダクションで使うか?正直まだ “設計次第で毒にも薬にもなる” フェーズ

個人的な結論をはっきり書くと、

-

PoC / プロトタイプ用途:

→ かなり積極的に使っていい。むしろ使わない理由があまりないレベル。 -

本番医療システムの中枢に据える:

→ 正直、まだ様子見。ただし、今のうちから前提に入れて設計しておく価値はある。

理由はシンプルで、

- LLM 自体の不確実性(幻覚・バージョン変更の影響)がまだ大きい

- コストとロックインのスキームが見えていない

- 規制側のスタンス(特に各国規制当局)がこれにどう反応するか不明

だからです。

これからやるべき現実的アクション(実務者向け)

とはいえ、「様子見」と言って何もしないのはもったいないので、

今できる現実的なアクションをいくつか挙げておきます。

- ユースケースの棚卸しをする

- 診断・治療:絶対に LLM に任せない領域

- 説明・要約・ドラフト:LLM に振れる領域

-

ログ・監査:完全に自前で責任を持つべき領域

をきれいに切り分ける。 -

LLM 抜きでも成立するワークフローを先に設計する

-

「AI が落ちた時にも回る運用」を前提にしておくと、

ChatGPT Health 採用・不採用に関わらず設計が健全になります。 -

ベンダーロックインを意識したアーキテクチャにする

- モデルアクセス用の Facade レイヤをきっちり作る

- プロンプト・テンプレ・フォーマットを極力ベンダー非依存に保つ

-

交換テスト(Mock モデル差し替え)を CI に入れる

-

責任分界をドキュメントに明文化する

- 「AI はここまで、人間はここから」という線を、

プロジェクト開始時に関係者全員で合意しておく。

まとめ:これは「医療AIの終着点」ではなく、「ようやくスタートラインに立った」だけ

ChatGPT Health の登場で、

- 「汎用GPTで無理やり医療ユースケースをやる」時代は終わりつつある

- これからは「医療特化 LLM プラットフォームをどう安全に組み込むか」の時代が始まる

と言っていいと思います。

ただし、これは

「LLM が医療のすべてを解決する」方向への一歩

というより、

「少なくとも PoC 止まりじゃない“マシな土台”が出てきた」

くらいの位置づけで見るのが妥当です。

正直、医療 × AI は技術よりも、

コスト・責任・倫理・運用の問題のほうが何倍も難しい領域です。

ChatGPT Health は、そのうち「技術的な土台」のハードルをだいぶ下げてくれます。

だからこそ、我々エンジニアと現場の実務者は、それ以外の難しい部分から逃げられなくなるとも言えます。

その意味で、今回の発表は「医療AIのスタートラインがようやく世界共通になった」というニュースだと捉えています。

ここから先、どんな設計とガバナンスで使うかが、本当の勝負です。

コメント