「LLMなに使うか会議」、毎回揉めてませんか?

MetaのLlamaにするか、DeepSeekにするか、はたまたクラウド専用モデルに寄せるか…。

その裏で、「どうせ全部NVIDIA GPUで動かすんだから、純正モデル出してくれよ」と内心思ったこと、ありませんか?🤔

その「GPU純正LLM」が、案の定出てきました。

NVIDIAのオープンソースLLMファミリ、その第3世代 「Nemotron 3」 です。

一言でいうと:「Llama界のKubernetes」をNVIDIAが出してきた

Nemotron 3 を雑にたとえると、

「Llama が Docker なら、Nemotron 3 は Kubernetes まで抱えた Google 的ポジションを NVIDIA が取りに来た」

そんな感じです。

- Meta は Llama で「オープンLLM」というコンテナ技術を広めた

- でもエンタープライズが本気で使うには、

モデルだけでなく 学習レシピ / 推論基盤 / 最適化ツール / ハードまで含めた“フルスタック” が欲しい - そこで出てきたのが、

- モデル(Nemotron 3 Nano/Super/Ultra)

- データセット

- トレーニングレシピ

- 実行スタック(TensorRT-LLM, Triton, CUDA…)

までまとめて「NVIDIAブランド」で出してくる動きです。

正直、めちゃくちゃ CUDA のときと同じ匂いがします。

GPGPU がバラバラだったころに CUDA を出して「GPU = NVIDIA前提」にしてしまった、あの流れ。

Nemotron 3 は、「生成AI = NVIDIA前提」 を、モデルレイヤまで拡張する一手に見えます。

何がそんなにヤバいのか:Nemotron 3 の「本当の意味」

「GPU純正 LLM」が出たインパクト

技術的には、Nemotron 3 そのものより 「誰が出してるか」 が本質です。

- GPUベンダー本人が

- Hopper / Blackwell に最適化されたアーキテクチャ(FP8/FP16、Tensor Core前提)

- TensorRT-LLM / Triton でそのまま最速パスが引ける前提のチェックポイント

- 分散学習・RLHF まで含めた NeMo ベースのレシピ

- それを オープンモデルとして配布

これ、エンタープライズからすると、

「NVIDIA GPU買って、NVIDIA AI Enterprise契約して、Nemotron 3 使っときゃ、

ベンチ取り直し地獄から解放されるのでは?」

という強烈な誘惑になります。

今までって、

- Llama / Mistral / Qwen / DeepSeek…

どれを選ぶか毎回検証 - それぞれ量子化や分散実行をチューニング

- 推論サーバも vLLM にするか Triton にするか自作か…

とにかく 「最適化責務が利用者側に押し付けられていた」んですよね。

Nemotron 3 では、

- モデル:Nemotron 3

- 推論:TensorRT-LLM

- サーバ:Triton

- 学習:NeMo + CUDA stack

という 「NVIDIA公式設計図」が丸ごと付いてくる。

これは、現場エンジニア的にはかなりデカいです。

Meta / Llama 一強体制が崩れてきたタイミングでの一撃

タイミングも絶妙です。

- Llama 4 は正直イマイチという評価が多く、LMSYS のランキングでも影が薄い

- Meta 自身も、今後の「Avocado」プロジェクトでクローズド寄りに振るという噂

- Menlo Ventures のレポートでは、

「企業でのオープンソースLLM利用比率が下がった要因の一つが Llama の停滞」 とまで書かれる始末

要するに、

「“オープンLLMの旗手 = Meta” だった構図が、2025年に入ってグラグラしている」

そのスキマに、NVIDIA が 「オープンソース LLM の新しい主役」 を取りに来ている、という構図です。

正直、

「Llama ベース前提で中長期ロードマップ描いてた企業は、一回立ち止まった方がいい」 レベル。

Nemotron 3 が “Llama殺し” になるかどうかはまだ分かりませんが、

- 「Llama 一択」だった世界が

- 「Llama / Nemotron / Qwen / DeepSeek を並べて比較する世界」

に変わるのは、ほぼ確定だと思います。

コミュニティが意外とポジティブな理由

面白いのは、OSS / ローカルLLM勢の反応です。

「ちゃんとオープンっぽい」ことへの安心感

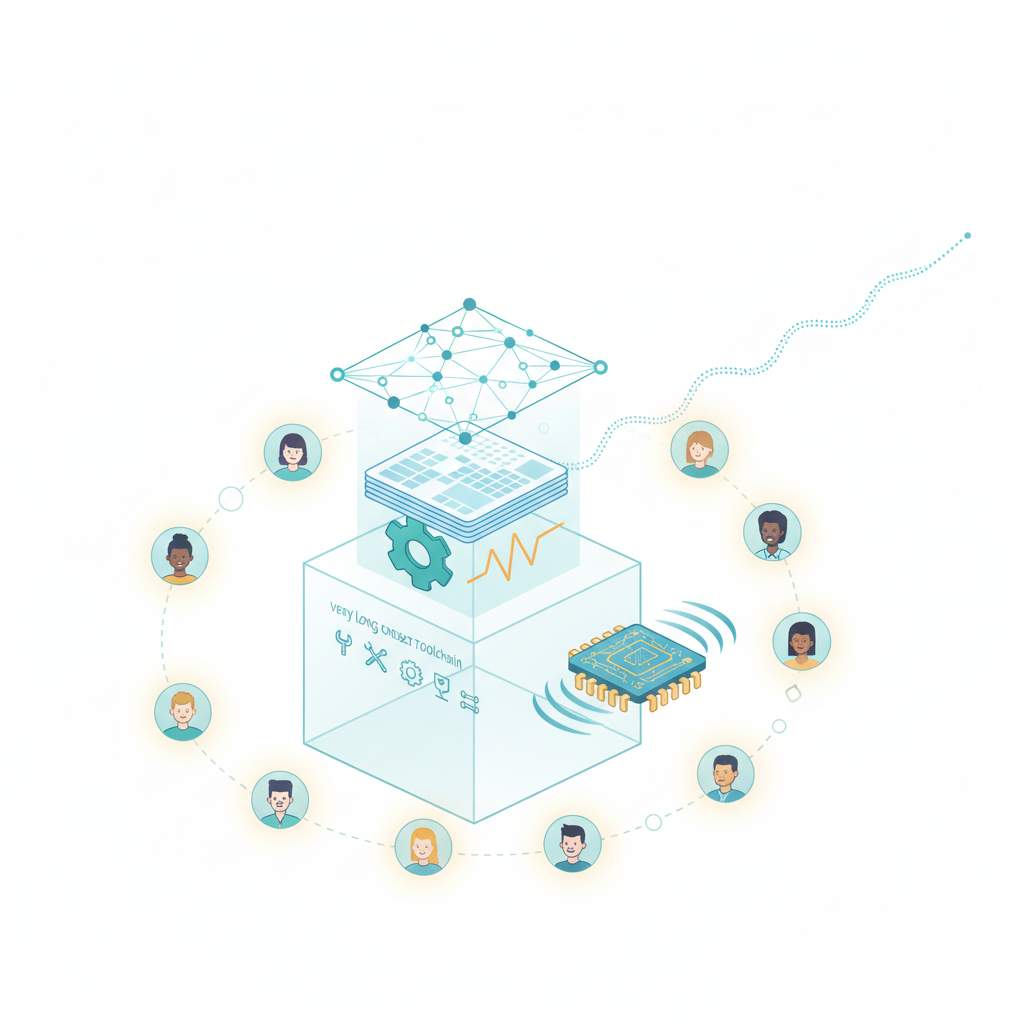

Nemotron 3 では、

- モデル重み

- データセット(少なくとも大部分)

- トレーニングレシピ

- 開発ツールチェーン

まで 「フルスタックで公開する」 という姿勢を打ち出しています。

多くのLLMがデータの出自をぼかす中で、

「事前学習コーパスまでかなり公開している」のはかなり評価されていて、

「これは嬉しい!本当にオープンソースですね」

という声も出ているくらい。

研究者目線でも、

- どんなデータに強いかが予測しやすい

- バイアスの分析・再現性の確保がしやすい

ので、実務だけでなく アカデミック界隈も巻き込もうとしている 感があります。

ローカルLLM勢からの期待

Nemotron 3 Nano は「エッジ・ローカル向け」の小型モデルで、

- 300B パラメータ級(Nano)

- 高効率・高スループット(従来比4倍)

- 100万トークンのロングコンテキスト対応

と、「ちゃんと実用ラインを狙ったSLM(Small-ish LLM)」 になっています。

コミュニティでは、

「これのおかげで、ローカルLLMを使ってる俺らも、将来もっともっと良い…」

みたいな声もあって、

Nemotron 3 そのものというより、今後の派生・改良モデルの“土台”として期待されている状況です。

技術的に何が嬉しいのか:開発者目線で分解してみる

Hopper / Blackwell 最適化前提のアーキテクチャ

Nemotron 3 は明確に、

- H100 など Hopper 世代

- 次世代 Blackwell

に最適化されています。

つまり、

- FP8 / FP16 混在で Tensor Core をフル活用

- TensorRT-LLM で量子化(INT8/FP8)込みの高速推論が前提

- 分散学習も NeMo + Megatron 系アーキテクチャでスケール

ハードとモデルを同じベンダーが握っている強み が、モロに出ている構造です。

ぶっちゃけ、

「H100 を買ったのに、サードパーティLLMを頑張ってチューニングしてました」

という状態から、

「NVIDIA純正の最適化済みLLMをそのまま使う」

方向にかなり流れると思います。

インフラ運用側からすると “標準解が増えた” のはかなりありがたい。

100万トークンのロングコンテキスト

Nemotron 3 の売りの一つが 100万トークンコンテキスト です。

この規模になると、

- RAGで「ファイル数十枚」どころか「部門Wiki全部」レベルを丸ごと食わせる

- 長期のマルチターン会話の履歴をほぼ落とさずに保持

- エージェント間でのマルチステップ推論でも「コンテキスト落ち」が起きにくい

といったメリットが出てきます。

正直、

「ここまで長いコンテキスト、本当に必要?」という疑問もありますが、

- エンタープライズRAG

- コードベース全体を対象にしたエージェント

- プロジェクト単位のチャット履歴を全部食わせるケース

あたりでは、そこそこ現実的なニーズがあります。

しかも MoE(Mixture-of-Experts)で効率を稼いでいるので、

「パラメータはデカいけど、推論時にアクティブな一部だけを使う」

という設計になっているのもポイントです。

とはいえ、懸念点もかなりハッキリ見えている

ベンダーロックインは、ほぼ確定で強まる

一番の懸念はここです。

表向きはオープンソースでも、実態としては

- 性能・最適化・ドキュメントが 完全に NVIDIA スタック前提

- TensorRT-LLM など最適化部分はかなりブラックボックス

- モデルを最大限活かすには「NVIDIA GPU + NVIDIA ソフトウェア」一択

という構図になります。

結果として、

- 今からNemotron 3 前提でプロダクションを組むと、

- 将来的に AMD / Intel GPU への移行コストがバカ高くなる

という “事実上のロックイン” が待っています。

正直、

「CUDA の再来」 を見ている感覚です。

コスト構造がエンタープライズ向けすぎる問題

Nemotron 3 は、明確に 企業・大規模ワークロード向け です。

- H100 / Blackwell 前提

- 大規模エージェント / ロングコンテキスト前提

- エンタープライズRAGや複雑なワークフローをターゲット

となると、

- 小規模スタートアップ

- 個人 / 小さなチームのプロジェクト

- コスト最適化が最優先のSaaS

には、オーバースペックになりがちです。

実務では、

- Mistral / Qwen / DeepSeek系の軽量モデル

- phi-3 / Gemma みたいなSLM

で十分なユースケースもかなり多い。

「NVIDIA純正だから」といって、

何もかも Nemotron 3 に寄せると、CAPEX/OPEXが普通に燃えます🔥。

エコシステムの複雑化:評価・プロンプト調整が地味にしんどい

Nemotron 3 が本格的に入ってくると、

- Llama 用に作り込んだプロンプト・評価パイプライン

- Qwen / DeepSeek 用の微調整

- これに Nemotron 3 用の調整がさらに加わる

という状態になります。

出力傾向がモデルごとにかなり違うので、

- 同じ評価セットなのにモデルごとに採点ロジックを変えたくなる

- ベンチ取りのためのinfra・スクリプトが肥大化

- 「この結果はモデル差なのか、プロンプト差なのか」が読みづらくなる

という、MLOps 的な面倒くささ が増えるのは覚悟した方がいいです。

Nemotron 3 vs Llama vs その他:どう使い分けるか

ここで、一度立ち止まってざっくり整理してみます。

ざっくり比較イメージ

- Nemotron 3(NVIDIA)

- 強み:

- NVIDIA GPU での最適性能

- フルスタック公式サポート

- データセット / レシピ含めた透明性

-

向き:

- H100 / Blackwell を握っているエンタープライズ

- 大規模RAG / エージェント / 長期運用前提の基盤モデル

-

Llama 系(Meta)

- 強み:

- コミュニティ資産が厚い

- 「オープンLLMの共通言語」としてのノウハウ蓄積

-

弱み:

- 最近の世代の伸び悩み

- Meta自身がクローズドに寄りつつある気配

-

Qwen / DeepSeek / Mistral など

- 強み:

- モデル単体の性能・コスパがかなり優秀

- ベンダーニュートラル寄り

- 向き:

- クラウド前提 or 自前GPUでもコスト意識強めのチーム

- ベンダーロックインを避けたい層

ぶっちゃけ、

「NVIDIA GPU をガッツリ買う企業」 にとっては Nemotron 3 はほぼ「自然な選択肢」になります。

一方で、

「マルチクラウド / マルチGPU戦略を維持したい企業」には、かなり慎重な検討が必要です。

結論:プロダクションで使うか?正直「今から前提にする」は様子見

エンジニアとしての本音を書くと、

- PoC・検証環境:

- ぜひ触っておいた方がいいです。

特に H100 / Blackwell を持っているなら、一度 Llama / Qwen / DeepSeek と横並びでベンチ を取る価値は大きい。 - 新規プロダクションの「唯一の前提モデル」にするか?:

- 正直、ここはまだ様子見です。

理由は3つあります。

- エコシステムの成熟度

- Llama や Qwen に比べると、Nemotron 3 の周辺ツール・知見はまだ少ない

-

2026年に Super / Ultra が出てからが本番、という見方もできる

-

ライセンス / 真の「オープン度」

-

現時点では概ねオープン寄りですが、

商用利用条件や NVIDIA AI Enterprise との抱き合わせ的なビジネスがどう転ぶか、もう少し見たいところです -

ロックインリスク

- モデル・推論・学習・GPU まで全部 NVIDIA に寄せると、

5年単位で見たときに 「技術戦略の柔軟性をかなり失う」 可能性がある

じゃあ、今なにをすべきか?

新規プロジェクトを設計するなら、個人的に強くおすすめしたいのはこれです👇

「モデル非依存レイヤー(LLM Adapter)」をちゃんと作る

- アプリケーションからは

generate()/chat()/embed()などの抽象インターフェースだけを見る- その下で

- Llama

- Nemotron 3

- Qwen / DeepSeek

の実装を切り替えられるようにする

LangChain / LlamaIndex に丸投げでもいいですが、

自社のコア部分だけは、自前の薄いAdapter層を噛ませておく のがおすすめです。

「NVIDIA前提」と「ベンダーニュートラル」の2系統を比較運用する

- オンプレ / 専用GPUクラスタ:Nemotron 3 + NVIDIAスタック

- クラウド / マルチ環境:Qwen / DeepSeek / Mistral あたり

を並行で回しつつ、

運用コスト・性能・チューニング容易性を1〜2年かけて比較 していくのが、現実的な落としどころかなと思います。

最後に:Nemotron 3 は「脅威」よりも「いい圧力」

正直に言うと、Nemotron 3 そのものよりも、

「GPUベンダーがオープンソースLLMまでフルスタックで出してくる」

という事実の方が大きいです。

これによって、

- Meta / Llama 陣営には「もう一段ギアを上げろ」というプレッシャー

- 他のオープンLLMベンダーには「フルスタックでどこまでやれるか」という競争

- そして我々開発者には

- 「モデル前提でロックインされない設計」

- 「複数モデルを前提にしたMLOps」

を真面目に考えろ、という宿題が突きつけられた形です。

Nemotron 3 をどう評価するかは人それぞれですが、

一つだけ言えるのは、

「Llama 前提で世界を語る時代は、もう完全に終わりつつある」

ということです。

その変化の波にちゃんと乗るかどうかは、

今のアーキテクチャ設計次第かなと思います。🚀

コメント