「社内ツールにClaude入れたいけど、トークン代で即死するんだよな……」

そんな悩み、ありませんか?

僕もここ1年くらい、「品質はClaudeクラス、でも自前で回せて桁違いに安いモデル」が出てこないかな〜と半ば諦めモードでいたんですが、正直ちょっと空気が変わりそうなモデルが出てきました。

MiniMax M2.1(MiniMax-Text-01-20250121)。

一言でいうと、

「Claude 3.5 Sonnet クラスの汎用モデルを、だいたい1/10コストで“ほぼOSS”として自前運用できるようになった」

という話です。

この記事はニュース紹介ではなく、

「これ、エンジニアとしてどう捉えるべきか?」をがっつり意見多めで書きます。

一言でいうと「LLM界の Docker が来たっぽい」

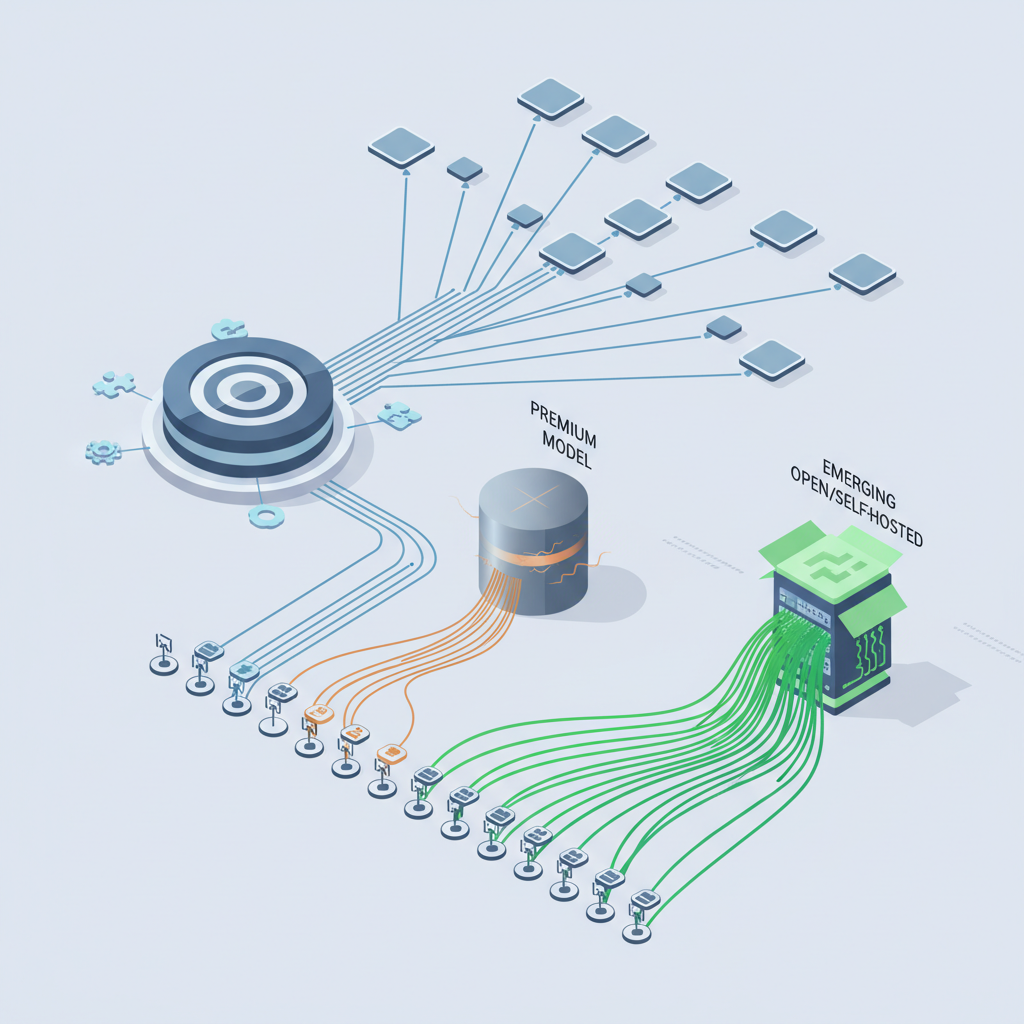

これ、個人的にはDocker が PaaS 全盛期をぶっ壊し始めた頃にすごく感覚が近いです。

- それまで:

- Heroku / App Engine みたいなマネージド PaaS に乗っかるのがラク

- でも自由度もコストも、長期的にはしんどい

- Docker 登場:

- 「Heroku っぽい体験を、自前インフラで・安く・自在に」

- 以降、インフラの主導権が一気にユーザー側に戻った

いまの LLM ってほぼ同じ構図ですよね。

- Anthropic (Claude)、OpenAI (GPT-4.x):

- めちゃくちゃ便利なマネージド LLM PaaS

- でも、高い・クローズド・ロックイン濃厚

- そこに MiniMax M2.1:

- 「Claude ソネット級の賢さを、重課金なしで、自前で回せる」

- 事実上 OSS な形でウェイト配布

正直、「あ、これ潮目変わるかも」と思いました。

何がそんなにヤバいのか:単なる“安いモデル”じゃない

性能が「Claudeライク」で“十分に実用レベル”

検証記事を読む限り、ざっくりこんな感じ:

- 日本語・英語ともにかなり自然

- 一般的な指示追従も素直

- コード生成・デバッグも「Claude 3.5 Sonnet 体感にかなり近い」

- 思考ステップ系の推論も、派手な穴はそこまで目立たない

つまり、

「商用プロダクトでClaudeを使っている典型的なケースなら、MiniMax M2.1でもだいぶ戦える」

レベルには来ている、という印象です。

もちろん「全てのケースでClaudeと完全互角」とまでは言えません。

でも現実のビジネスユースって、そこまで尖った SOTA 推論を要求してないことが多いんですよね。

- FAQボット

- 社内ナレッジQA

- 簡易ドキュメント生成

- コーディング支援 / PRレビューの下書き

このあたりは、「Claudeライクで8〜9割の品質」出れば、実務的にはもう十分強い。

コストが「桁違い」:だいたい1/10

ここが一番インパクト大きいところ。

- Claude 3.5 Sonnet などのAPI課金:

- 重いユースケースだと、あっという間に数十万〜数百万円/月

- MiniMax M2.1 を自前GPUでホスティング:

- A100/H100 までいかなくても、ちゃんとしたGPU数枚と高い稼働率が確保できれば

- 実効トークン単価が Claude のざっくり1/10程度 まで落ちる試算

ぶっちゃけ、

- 月数千万〜数億トークン使うようなワークロード

- 常時動き続けるエージェント系処理

をやろうとしたとき、

「APIで全部Claude/GPT-4」は、もはや数字が合わないんですよね。

MiniMax M2.1 クラスが安定して動くなら:

- コアとなるアシスタント機能は MiniMax で

- どうしても品質を落としたくないクリティカルな一部フローだけ Claude / GPT-4 に逃がす

みたいなハイブリッド構成が、現実的な線になってきます。

「事実上OSS」=ロックインからの脱出装置

ライセンス上は「完全OSS」とまでは言わないほうがよさそうですが、実態として:

- ウェイトをダウンロード可能

- vLLM や text-generation-inference などの汎用スタックでそのまま動く

- OpenAI互換APIで公開も簡単

ということで、

「自前インフラ上で、Claudeクラスのアシスタントを“ほぼOSS”として扱える」

状態になりつつあります。

これが意味するのは、

- 特定ベンダーに完全ロックインされない

- リージョン・コンプラ要件に合わせてVPC内完結が可能

- 必要なら自分で微調整や追加チューニングもできる(ライセンス要確認ですが)

という、「選択肢」が一気に広がるということです。

なぜこのニュースがそんなに重要なのか:誰が一番困るのか

ここからは、完全に僕の主観です。

一番プレッシャーを感じるのは Claude / Mid-tier ベンダー

OpenAI は正直、まだしばらく安泰だと思います。

理由は簡単で、「モデル」だけじゃなく「プラットフォーム」を売っているから。

- 凝ったツール呼び出し

- オーケストレーション

- エコシステム全体との統合

ここはMiniMax含むOSS勢がすぐに追いつける領域ではない。

一方で、Anthropic (Claude) はかなり直球の競合を喰らう印象です。

- 売り:

- 高品質なテキスト・コード・推論

- 安心感のあるアライメント・セーフティ

- でも:

- 完全クローズド&APIオンリー

- コストは高め

そこに、

- 品質:体感 Claude 3.5 Sonnet にかなり寄せてくる

- コスト:うまく回せば1/10

- 自前ホストOK

という MiniMax M2.1 が来ると、

「高トラフィックの9割をMiniMaxに逃がし、残りの1割だけClaudeに」

という発想が、企業側にとってかなり魅力的になってしまう。

さらにキツいのは、

「GPT-4/Claudeほどじゃないけど、うちのLLMは安いです」系のクローズド中堅ベンダー。

- 「GPT-4 よりちょい劣るけど、コスパはいいよ!」

というポジションそのものが、 - 「MiniMax M2.1 自前運用すればよくない?」

で、一気に薄くなってしまう。

この層は正直、生存戦略をガチで考え直さないと厳しいです。

エンタープライズのAI戦略が“インハウス寄り”に振れる

企業側の視点で見ると、

- コンプラ・監査・データレジデンシ

- 内部ログの扱い

- SLAを自社コントロール下に置きたい

といった事情から、

「LLMも、そのうち自社インフラで回したいよね」という要望はずっとくすぶっていました。

ただ、これまでは:

- OSSモデル:

- コストは安いけど、性能が「GPT-4/Claudeと比べるとだいぶツラい」

- クローズドAPI:

- 性能は最強クラスだけど、コストとロックインがしんどい

という二択だったのが、

「Claudeライクな性能で、OSSにかなり近い形で自前運用できる」

という第三の選択肢が実用レベルに乗ってきた。

正直、これが5〜10個積み上がった時点で、

「LLMはインフラとして自社で持つ」のが当たり前

という空気にかなり近づくと思っています。

ただし「夢のモデル」ではない:ガチな懸念ポイント

ここまで褒め気味に書きましたが、現実的な懸念もそれなりにあります。

自前ホスティングの運用コストは、ガチで重い

ぶっちゃけ、多くのチームが見落としがちなのがここ。

- GPU確保(オンプレ or クラウド予約)

- オートスケール、負荷分散

- モニタリング・ログ・トレーシング

- モデル更新・ロールバックの手順

- セキュリティパッチや障害対応

これ全部、自分たちでやる覚悟がいる。

小さめのSaaSやスタートアップだと、

「Claude API高いけど、MLOpsチームを1〜2人抱えるよりは、

素直にAPI課金したほうがトータル安いよね」

というケースは普通にありえます。

トークン単価1/10は魅力的ですが、

TCO(Total Cost of Ownership)で見たときに本当に得かどうかは、冷静に試算したほうが良いです。

ライセンスと法務のチェックはマスト

記事では「事実上 OSS 的に使える」と書かれていますが、

- 商用利用の範囲

- 再配布の可否

- 自社サービスに組み込んだときの条件

- 地域・業種ごとの制限

など、法務がちゃんと読むべきポイントはいくつもあります。

「オープンウェイトだからOSSっしょ」とノリで判断すると、

後から割とシャレにならないことになりかねないので、ここは冷静に。

「Claude同等」ではなく「Claudeクラス」であること

ここも期待値コントロールの話です。

MiniMax M2.1 は、

- 実務ベースで「Claude 3.5 Sonnet っぽい挙動をすることが多い」

- でも細かく比べると、ところどころで負ける

というポジションであって、

「あらゆる状況でClaudeと同じ回答を出せる」

わけではありません。

特に心配なのは:

- レアケースの推論

- 多段のツール呼び出しを伴う複雑ワークフロー

- 繊細なニュアンスのライティング

このあたりは、

「本番トラフィックをミラーしてA/B比較」くらいまではやらないと、

いきなり全面移行するのは怖いです。

セーフティとアライメントは自分たちで担保する時代へ

Claude の強みの1つは、何だかんだ安全性のチューニングが非常に手厚いことです。

- 有害コンテンツの抑制

- 敏感トピックへの配慮

- 「答えない勇気」を持った拒否挙動

これに比べて、MiniMax M2.1 などの OSS ライクモデルは、

- そこそこ安全に作ってはいるものの

- 「Anthropicレベルのレッドチーミングとガバナンス」が乗っているとは限らない

なので、

- 医療

- 金融

- 子ども向けサービス

- 法務系

みたいな領域で使う場合は、

自前で追加のガードレールをかける前提で設計したほうがいいです。

- 外側に安全フィルタをかませる

- プロンプトで制約を強くかける

- 応答ログを人間が監査する

など、面倒ですが避けて通れません。

じゃあ、プロダクションでいきなり使うべき?僕の結論

正直に言うと、

「いきなりフル移行は推奨しないけど、

今から真面目に検証しないチームは、1〜2年後に後悔する 可能性が高い」

というのが僕の立場です。

こういうチームは、真剣に触り始めたほうがいい

- すでに Claude / GPT-4 を

- 月数十万〜数百万トークン以上使っている or 使う予定

- 社内向けのCopilot / FAQボット / ナレッジ検索など

典型的な「Claudeで十分なユースケース」が多い - 社内にインフラ / MLOps を1〜2人でもちゃんと担当できる人がいる

- セキュリティ・コンプラの観点から

「最終的にはVPC内で閉じたい」プレッシャーが強い

こういう環境なら、

- まず vLLM などで MiniMax M2.1 の簡易サーバーを立てる

- OpenAI互換APIで、自社アプリからの呼び先だけ差し替える

- 同じリクエストを Claude / GPT-4 にも飛ばして A/B 比較

- 成功率・ユーザー満足度・コスト・事故率を1〜2週間計測

- 「品質許容ライン」を超えた部分だけ MiniMax に切り替える

みたいな段階的移行が現実解だと思います。

逆に、まだ様子見でいいチーム

- LLM利用量がそこまで多くない

- プロダクトよりも、まずはPoC・実験段階

- インフラに人を割く余裕がない

- 「品質最優先で、とにかく一番賢いモデルを使いたい」

このあたりなら、正直まだ:

- Claude / GPT-4 を素直に使う

- コストは「学習コスト」と割り切る

でも全然アリです。

「安さのために開発速度を落とす」のは、本末転倒なので。

最後に:LLMは「SaaSからインフラ」へ確実にシフトしていく

MiniMax M2.1 が、

Docker 1.0 ぐらいの歴史的インパクトになるかどうかは、まだ分かりません。

でも、

- Claudeクラスの汎用アシスタント

- 事実上OSS

- 自前ホスティングで1/10コスト

というコンビネーションは、

「LLMはクラウドSaaSにお任せ」一辺倒の時代の終わりの始まり

として見るのが妥当だと思っています。

ぶっちゃけ、

「うちのビジネスは“LLMのAPIを安く叩けること”で差別化してます」

みたいな会社は、

こういうモデルが増えれば増えるほどかなり厳しくなるはずです。

これから価値が出るのは、

- モデルそのものではなく

- モデルをどう組み合わせ、ワークフローとデータに落とし込むか

というレイヤー。

MiniMax M2.1 の登場は、その方向性をかなりはっきり可視化してくれた感じがします。

まとめ

- MiniMax M2.1 は「Claude 3.5 Sonnet クラスを1/10コスト + ほぼOSS」で自前運用できるモデル

- これは Docker が PaaS を揺さぶった瞬間 に似ていて、

LLM を「自社インフラとして持つ」という選択肢を一気に現実化させる - ただし、運用コスト・セーフティ・ライセンスなど、甘く見てはいけないポイントも多い

- 僕の結論:

- 高トラフィック+インフラ体制があるチームは、今すぐ検証すべき

- そうでないチームは、ニュースをウォッチしつつ、1〜2年のうちに「インハウスLLM戦略」を真面目に考え始めるタイミング

正直、

「API課金地獄から脱出したいエンジニア」にとっては、かなりワクワクする展開です 🤔

皆さんの環境だと、どの部分なら MiniMax に置き換えられそうか、一度冷静に棚卸ししてみる価値はあると思います。

コメント