「社内の検証はローカルで回したいけど、

GPUもしょぼいし、日本語だと結局クラウド頼み…」

そんな悩み、ありませんか?

その“隙間”を、かなり危険な精度で突いてきたのが Liquid AI LFM2.5-1.2B です。

しかも、LM Studio からポチポチするだけでローカル実行できる。

正直、「これはローカル LLM 界の Docker 元年かもしれないな」と感じました。

一言でいうと、「LLM界の Docker がついに来た」感

LFM2.5 を雑にまとめると:

「1.2B なのに、ちゃんと“仕事で試せる”ローカル LLM」

です。

かつてインフラは、

- 物理サーバ or どでかい VM しかなくて

- 「とりあえず自分のマシンでサクッと再現」が地獄

だったところに Docker が来て、

「軽くてそこそこちゃんと動くコンテナ」 で世界が変わりましたよね。

今の LLM も、かなり似た構図です:

- クラウドの 70B クラス:強いけど高い・遅い・扱いづらい

- ローカル 1〜3B クラス:軽いけど「ちょっとおバカ」なことが多い

ここに LFM2.5-1.2B が、

- パラメータたった 1.2B

- でも 多言語・そこそこの推論・長めコンテキスト

- しかも CPU / 貧弱 GPU でも実用レベルの速度

という、かなりズルいポジションで踏み込んできました。

何がそんなにヤバいのか:llm-jp-3.7B とガチ比較して見えたもの

検証記事では、主にこの構図で比較されています:

- LFM2.5-1.2B

- llm-jp-3.7B(日本語特化・約3.7B)

- + 各種自作 LoRA モデル

結論からいうと:

「日本語の自然さ・安定感は llm-jp だけど、

“軽さと汎用性” で LFM2.5 が一気にデフォルト候補になった」

という感じです。

体感性能:1.2B にしては“やけに賢い”

- 日常 QA、簡単な要約、ライトなコード補完くらいなら

→ LFM2.5-1.2B で「まあこれでいいか」と思えるレベル - 特に英語や多言語タスクはかなり強い

- 日本語も「崩壊している」レベルではなく、

普通の会話・要約なら普通に通る

一方で llm-jp-3.7B は、

- とにかく日本語が自然で安定

- ビジネスメール、長文の構成、敬語のニュアンスなどは明らかに上

ただし、それと引き換えに:

- モデルサイズで約 3 倍

- 同じマシン上でのレイテンシは「体感で別物」

- VRAM / RAM の消費も重い

開発者視点だと、こういうトレードオフになります:

-

ローカルで軽く・多言語込みで遊びたい/検証したい

→ LFM2.5-1.2B -

日本語業務テキストをガチ運用したい

→ まだ llm-jp-3.7B 優勢

「LoRA 頑張る」文化へのカウンターパンチ

検証記事でおもしろいのは、

「既存モデル + 自作 LoRA」 vs 「LFM2.5-1.2B 素のまま」

の比較です。

ざっくりいうと:

- これまで:

「ベースモデル微妙だけど LoRA を盛ればなんとかなるでしょ」 - これから:

「ぶっちゃけ、最初から強い 1.2B ベースを選んだほうが早くない?」

というムードが見えます。

正直、LoRA で「そこそこ」を出すのって、

- データ集め

- スクリプト整備

- 評価・やり直し

…全部ちゃんとやると、ほんとに骨が折れます。

そこに 「最初から 1.2B でこの精度ですけど?」 と殴り込まれると、

「もうベースモデル差し替えで済ませたい」 という誘惑が一気に強まります。

実際にローカルで回すとどうか:LM Studio 前提で考える

今回の検証は、かなり現実的な環境を想定しています:

- 一般的な Windows / macOS PC

- CPU: Core i7 / Ryzen クラス

- GPU: RTX 3060 / 4060(8〜12GB)あれば御の字、最悪 GPU なしでも OK

- RAM: 16〜32GB

セットアップの現実感

LM Studio 前提だと手順はほぼこれだけ:

- LM Studio インストール

- モデルタブで

LFM2.5を検索 LFM2.5-1.2B(Instruct / JP)あたりを gguf でダウンロード- そのままチャット開始

正直、「Qiita 勢」じゃなくてもいけます。

“VS Code いじれるエンジニア/パワーユーザー” なら余裕の世界。

ここがかなり大きいです。

「ローカル LLM」は、これまで「好き者の遊び場」感が強すぎた

のですが、LFM2.5 + LM Studio だと

- “普通の開発者” が “普通に PoC に使える” ラインに落ちてきた

という印象です。

「なにが変わるのか」をちゃんと整理する

ちょっと冷静に、開発者目線でのインパクトを整理します。

ローカル LLM が「真面目な選択肢」になる

これまでも「ローカルで LLaMA 動かしてみた」系の記事は山ほどありましたが、

実務に載せるとき、結局こうなっていたはずです:

- 結局、品質不足でクラウド API に戻る

- あるいは「RAG の前処理くらいなら…」と、用途がかなり限定

LFM2.5-1.2B でようやく、

- プロトタイピング

- 開発環境の補助

- 社内ツールの軽いチャットボット

くらいまでは、

「クラウドなしでも現実的に回せる」 レベル感に来ました。

特に、

- セキュリティ・コンプラが厳しい現場

- オフライン前提(現場端末・工場・車載など)

には、インパクトがデカいです。

GPU 貧弱勢にとっての「最後の一押し」

- VRAM 8GB クラス

- あるいは CPU-only だけどそこそこコア数はある

こういう環境は日本の中小企業・SIer だとまだまだ主流です。

そこに対して、

- 1.2B の量子化 gguf(1〜2GB 級)でサクッと動き

- レスポンスも「ストレスにならない」レベル

というのは、かなり刺さるはずです。

「強くはないが、常にそこにいてくれるローカル相棒」

として、エディタの横・社内ツールの裏側に置く、

そんな設計が現実的になります。

ぶっちゃけ、ここが弱い:LFM2.5 の “Gotcha” たち

もちろん、万能ではありません。

むしろ、過度な期待は危険です。

1.2B の「物理的な天井」は、どうしても超えられない

いくらアーキテクチャが良くても、1.2B は 1.2B です。

- 複雑なコード生成

- ドメイン特化の深い QA(医療・法律・会計など)

- 長い思考チェーンが必要な推論タスク

こういうのは、正直まだクラウド LLM の領域です。

検証記事でも、

- 日常 QA

- シンプルな要約

- 軽いタスク

あたりに絞って評価されています。

「ChatGPT 代替」と勘違いして丸投げすると痛い目を見る パターンです。

日本語は「実用寄り」止まり、llm-jp の牙城はまだ堅い

LFM2.5 には 日本語特化の LFM2.5-1.2B-JP もありますが、

それでも、

- 敬語・ビジネス文書のトーン

- 長文構成力

- 細かいニュアンスの言い回し

では、まだ llm-jp 系に分があります。

業務でよくあるこの辺り:

- 契約書ドラフト

- 役員向け説明資料の素案

- 顧客向けお詫びメール案

は、正直まだ LFM2.5 単独では怖い です。

レビュー付き前提にしても、

「日本語文書ツールのメインエンジン」には早すぎる 感じがあります。

エコシステムの成熟度は、まだこれから

LLaMA / Mistral / llm-jp に比べると、

- SDK / ライブラリの標準的なサポート

- PoC 事例・運用ノウハウ

- ベストプラクティス記事

が、まだ少ないです。

今は完全に 「アーリーアダプタ用」 のフェーズ。

企業がメインの基盤モデルに据えるには、まだ時間が必要 です。

ライセンス&プロジェクト継続性という「静かなリスク」

LFM2.5 は Liquid AI 独自ライセンス(LFM Open License) で、

- 年商 1,000万ドル未満なら商用無料

- それ以上は別途契約

という条件付き。

スタートアップや日本の中小企業からすると、

「いざ伸びたときにライセンス交渉が発生する」 のは、地味にリスクです。

また、新興プロジェクトなので、

- 今後のアップデート継続性

- モデルラインナップの方向性

- 商用サポートの質

も、まだ読みにくい。

「これ前提で 5 年スパンの大規模システムを組む」のは時期尚早 かな、と思います。

じゃあ、どこでどう使うのが“現実解”か?

ここが一番重要な話だと思っています。

「検証・PoC・開発用ローカルコパイロット」として

まずはここが鉄板だと感じています:

- 開発チームの ローカル補助エージェント

- 社内 PoC のプロトタイピング

- オフライン環境での動作検証

この用途だと、

- クラウド課金を気にせずガンガン回せる

- 機密データもローカルだけで閉じられる

- ハード要件もそこまで高くない

という LFM2.5 の強みが、ド直球で刺さります。

「RAG の前段」としての組み込み

もう少し踏み込んだ使い方として、

- 検索部分は別途(Elasticsearch / PGVector 等)

- コンテキストの要約・整形・回答生成を LFM2.5 に任せる

という 軽量 RAG エンジン の構成です。

ここで重要なのは、

“モデルが全部を知っている” 必要はなくて、

“渡されたコンテキストをそこそこうまく料理できればよい”

という割り切りです。

このレイヤーなら、

- 1.2B でも十分仕事になる

- GPU もそこまでいらない

- オンプレ完結も現実的

になってきます。

「クラウド LLM のサイドカー」として併用する

個人的に一番面白いと思っているのはこれです:

- 通常時:

- 軽い問い合わせ → LFM2.5 ローカルで処理

- 重い問い合わせ / 重要タスク:

- クラウド LLM(OpenAI / Claude / Gemini 等)にエスカレーション

つまり、「ローカル LLM を API のフロントにかませる」 形です。

メリットは:

- 通信コスト・レイテンシの削減

- クラウド API のコール数圧縮

- 障害時(ネットワーク断)でも最低限の応答は継続できる

この構成だと、

LFM2.5 は “全部をこなすヒーロー” ではなく、

“99% の雑務をさばく有能なバイトくん” のポジションになります。

この割り切りができると、一気に使い道が広がります。

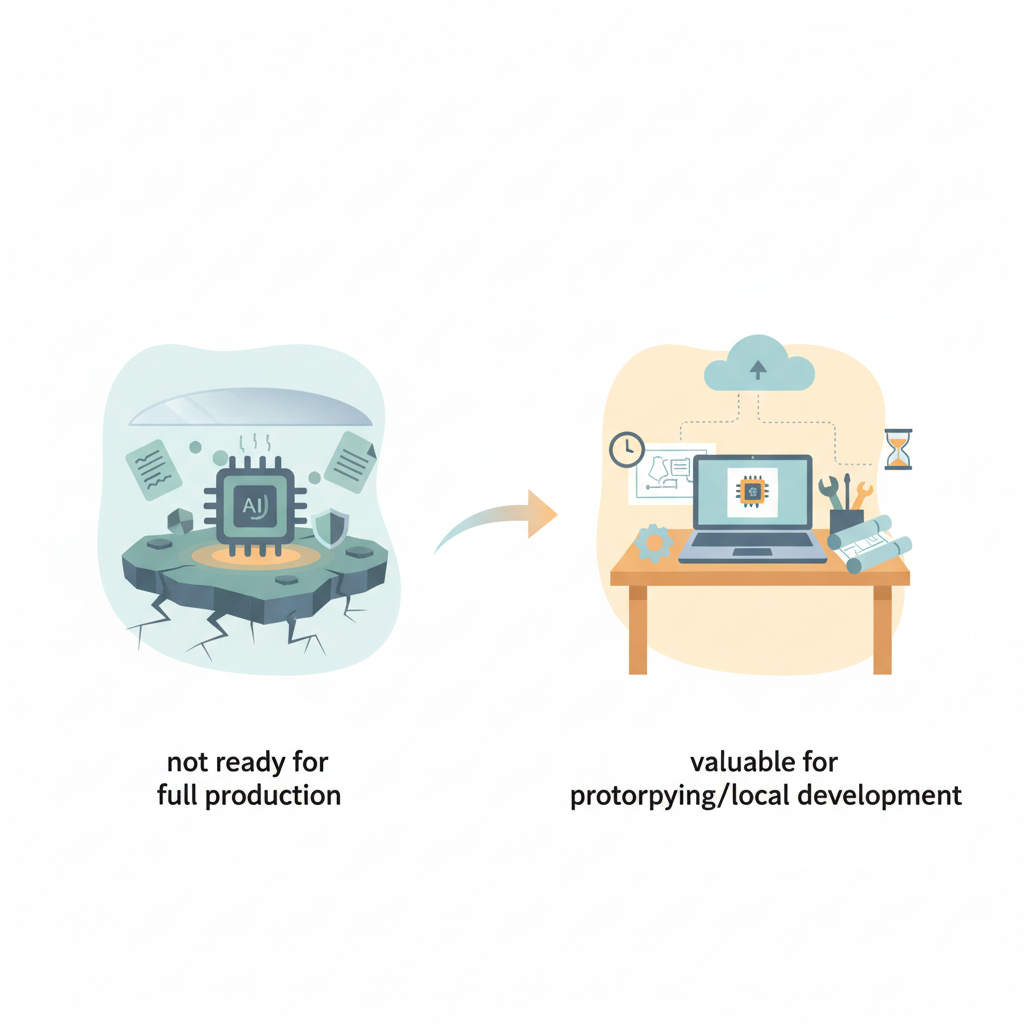

「プロダクションで使うか?」に対する、正直な結論

率直にまとめます。

- プロダクションのメインエンジンとして、全面採用するか?

→ 正直、まだ様子見です。

理由は:

- 1.2B の性能天井

- 日本語業務テキストでの不安

- ライセンス&継続性の不確実性

- エコシステムの成熟度

あたり。

一方で、

- PoC / プロトタイピング / ローカル開発用途として触る価値があるか?

→ むしろ「今のうちに触っておくべき」レベル だと思っています。

というのも、

「軽量ローカル LLM のデフォルト選択肢は、

今後 1〜2 年でガラッと変わる」

と見ているからです。

そのときに、

- LFM 系の「設計思想」

- 1〜2B クラスでどこまでできるかの感覚

- ローカル + クラウド ハイブリッド構成の勘所

を持っているかどうかで、

設計の引き出しがだいぶ変わる はずです。

いますぐできる “現実的な一歩”

最後に、実務エンジニアとしての「やるならここから」を挙げておきます:

- LM Studio を入れて LFM2.5-1.2B を回す

- Instruct と JP の両方を触ってみる

-

同じ環境で

llm-jp-3.7Bも回して、速度・品質を感覚として掴む -

自分のユースケースで「どこまでローカルでいけるか」試す

- 自社の FAQ

- 社内ドキュメント要約

-

開発補助(軽いコードレビュー・コメント生成)

-

クラウド LLM とのハイブリッド案を妄想する

- 「ここまでは LFM2.5、ここからは GPT」という境界を決めてみる

- その分だけクラウドコストがどれくらい下がるかをざっくり試算してみる

「全部クラウドに投げておけばいい時代」は、

コスト・レイテンシ・プライバシー の観点で、もう限界が見えています。

LFM2.5 は、その先の世界――

「そこそこ賢い AI が、どの PC にも常駐している」 未来への、

かなり具体的な一歩です。

ローカル LLM をまだ “おもちゃ” だと思っているなら、

一度 LFM2.5-1.2B をローカルで回してみるといいと思います。

たぶん、最初の一言を返してくるまでの速さと質で、

少しだけ価値観がズレるはずです。

コメント